Sommario:

Punti Chiave

- Grandi aziende come Open AI, Google, Microsoft e Meta stanno investendo nei SLM.

- Gli SLM stanno guadagnando popolarità in tutto il settore e sono meglio posizionati come il futuro dell’AI.

- Esempi di SLM includono Google Nano, Phi-3 di Microsoft e GPT-4o mini di Open AI.

I modelli di linguaggio di grandi dimensioni (LLM) hanno fatto la loro comparsa con il rilascio di ChatGPT di Open AI. Da allora, diverse aziende hanno lanciato i propri LLM, ma sempre più aziende stanno ora optando per i modelli di linguaggio di piccole dimensioni (SLM).

Gli SLM stanno guadagnando slancio, ma cosa sono e come si differenziano dagli LLM?

Che cos’è un Modello di Linguaggio di Piccole Dimensioni?

Un modello di linguaggio di piccole dimensioni (SLM) è un tipo di modello di intelligenza artificiale con un numero inferiore di parametri (puoi pensarlo come un valore nel modello appreso durante l’addestramento). Come i loro omologhi più grandi, gli SLM possono generare testo e svolgere altre attività. Tuttavia, gli SLM utilizzano insiemi di dati minori per l’addestramento, hanno meno parametri e richiedono meno potenza computazionale per essere addestrati e funzionare.

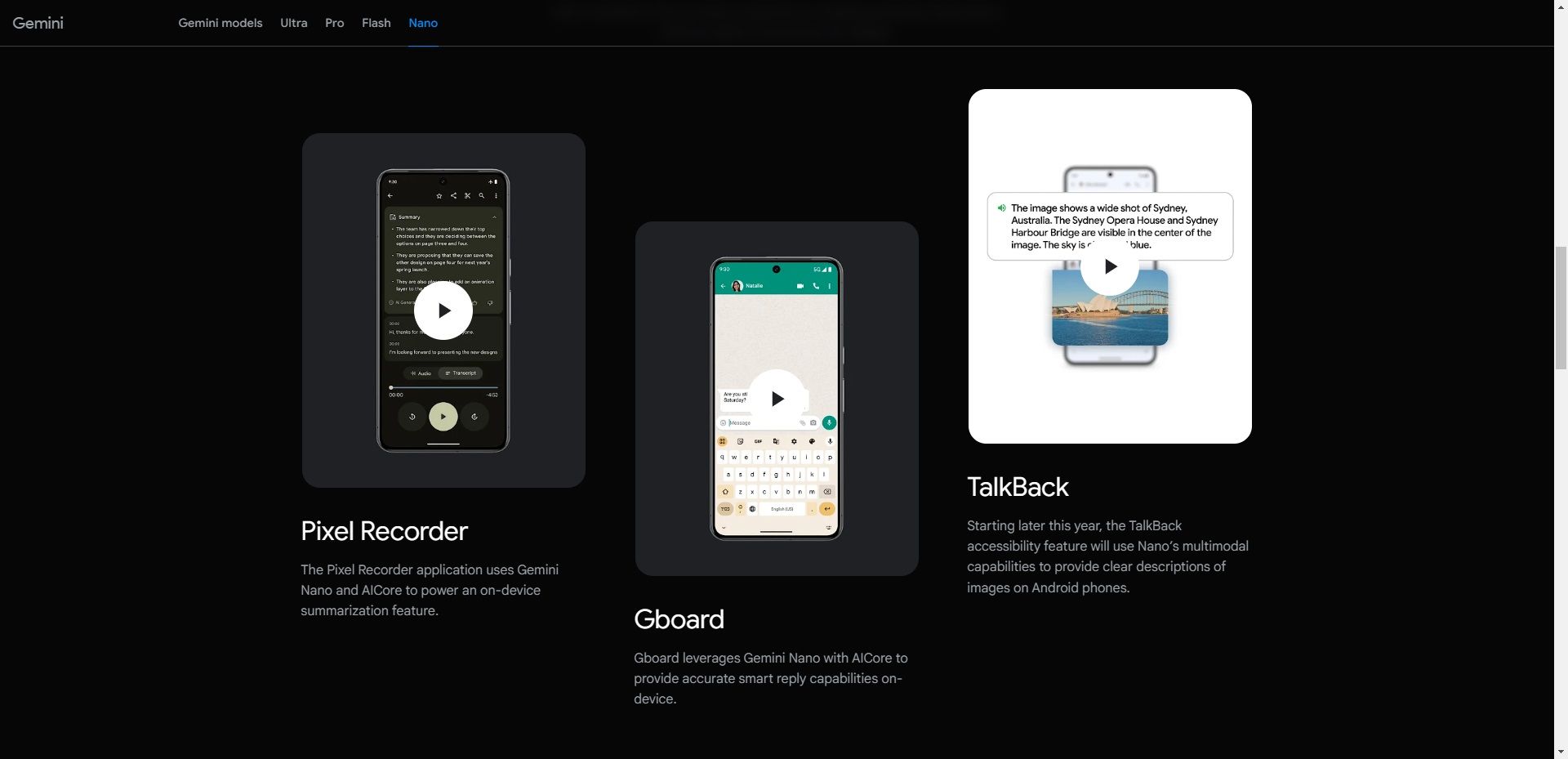

Gli SLM si concentrano sulle funzionalità chiave e il loro ingombro ridotto significa che possono essere distribuiti su diversi dispositivi, inclusi quelli che non hanno hardware di alta gamma come i dispositivi mobili. Ad esempio, il Nano di Google è un SLM on-device concepito da zero per funzionare su dispositivi mobili. Grazie alle sue dimensioni ridotte, il Nano può funzionare localmente con o senza connettività di rete, secondo l’azienda.

Oltre a Nano, ci sono molti altri SLM provenienti da aziende leader e emergenti nel settore dell’AI. Alcuni SLM popolari includono Phi-3 di Microsoft, GPT-4o mini di OpenAI, Claude 3 Haiku di Anthropic, Llama 3 di Meta e Mixtral 8x7B di Mistral AI.

Ci sono anche altre opzioni disponibili, che potresti pensare siano LLM ma sono SLM. Questo è particolarmente vero considerando che la maggior parte delle aziende sta adottando un approccio multi-modello, rilasciando più di un modello di linguaggio nel proprio portafoglio, offrendo sia LLM che SLM. Un esempio è GPT-4, che ha vari modelli, tra cui GPT-4, GPT-4o (Omni) e GPT-4o mini.

Modelli di Linguaggio di Piccole Dimensioni vs. Modelli di Linguaggio di Grandi Dimensioni

Quando si parla di SLM, non possiamo ignorare i loro grandi omologhi: gli LLM. La differenza principale tra un SLM e un LLM è la dimensione del modello, che viene misurata in termini di parametri.

Al momento della scrittura, non esiste un consenso nell’industria dell’AI sul numero massimo di parametri che un modello non dovrebbe superare per essere considerato un SLM o sul numero minimo necessario per essere considerato un LLM. Tuttavia, gli SLM tipicamente hanno milioni o qualche miliardo di parametri, mentre gli LLM ne hanno di più, arrivando fino a trilioni.

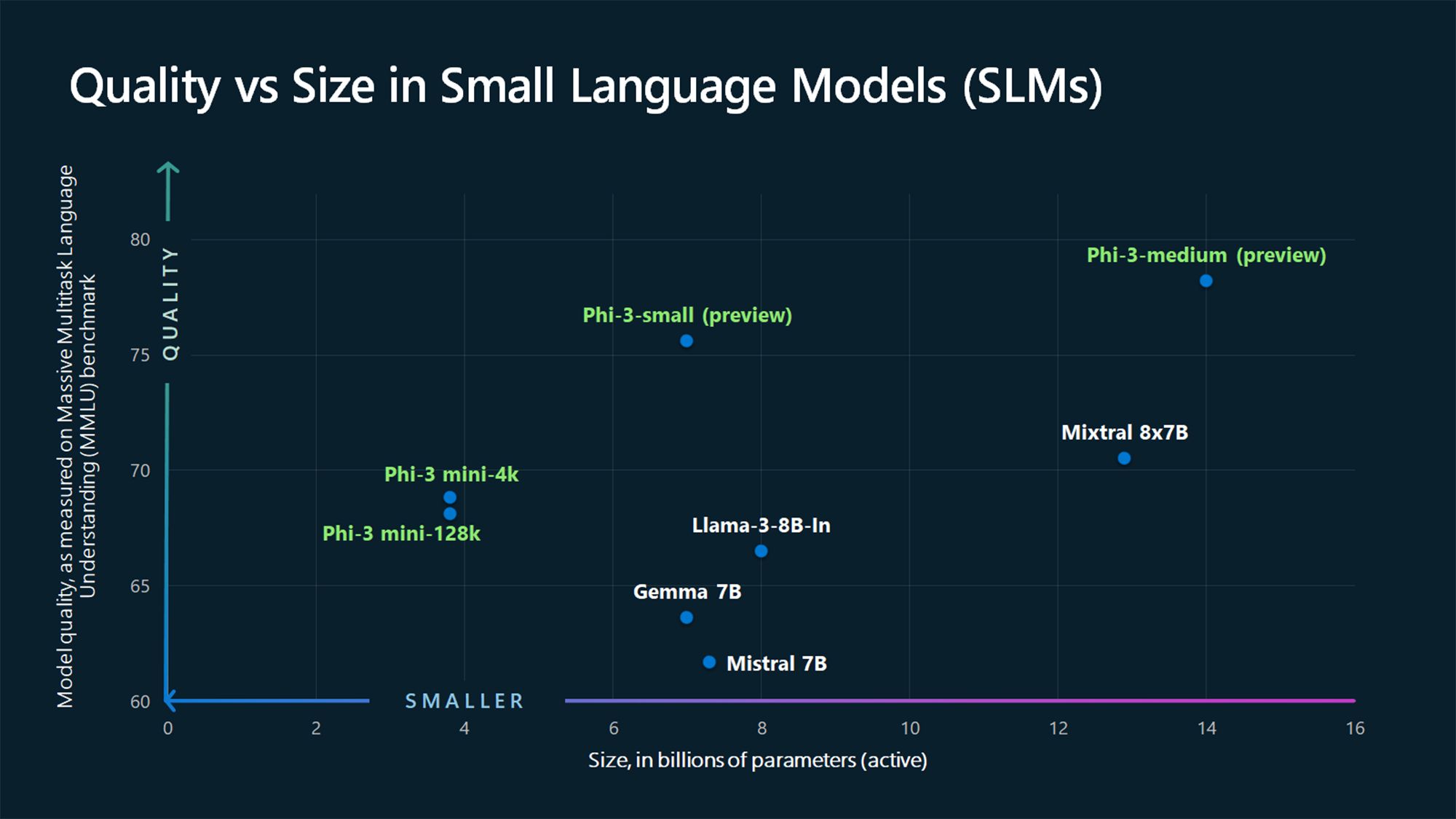

Ad esempio, GPT-3, rilasciato nel 2020, ha 175 miliardi di parametri (e si vocifera che il modello GPT-4 ne abbia circa 1,76 trilioni), mentre i SLM Phi-3-mini, Phi-3-small e Phi-3-medium di Microsoft del 2024 misurano rispettivamente 3,8, 7 e 14 miliardi di parametri.

Un altro fattore distintivo tra SLM e LLM è la quantità di dati utilizzati per l’addestramento. Gli SLM vengono addestrati su volumi di dati minori, mentre gli LLM utilizzano grandi insiemi di dati. Questa differenza influisce anche sulla capacità del modello di risolvere compiti complessi.

A causa dei grandi dati utilizzati nell’addestramento, gli LLM sono più adatti a risolvere diversi tipi di compiti complessi che richiedono ragionamento avanzato, mentre gli SLM sono più adatti per compiti più semplici. A differenza degli LLM, gli SLM utilizzano meno dati di addestramento, ma i dati utilizzati devono essere di qualità superiore per raggiungere molte delle capacità presenti negli LLM in un pacchetto ridotto.

Perché i Modelli di Linguaggio di Piccole Dimensioni Sono il Futuro

Per la maggior parte dei casi d’uso, gli SLM sono meglio posizionati per diventare i modelli principali utilizzati da aziende e consumatori per eseguire una vasta gamma di compiti. Certo, gli LLM hanno i loro vantaggi e sono più adatti per determinati casi d’uso, come la risoluzione di compiti complessi. Tuttavia, gli SLM sono il futuro per la maggior parte dei casi d’uso per i seguenti motivi.

1. Costi di Addestramento e Manutenzione Inferiori

Timofeev Vladimir/Shutterstock

Timofeev Vladimir/Shutterstock

Gli SLM necessitano di meno dati per l’addestramento rispetto agli LLM, il che li rende l’opzione più viabile per privati e piccole e medie imprese con dati di addestramento limitati, finanze o entrambi. Gli LLM richiedono grandi quantità di dati di addestramento e, di conseguenza, necessitano di enormi risorse computazionali sia per l’addestramento che per l’esecuzione.

Per comprendere meglio, il CEO di OpenAI, Sam Altman, ha confermato che per addestrare GPT-4 hanno speso più di 100 milioni di dollari, parlando in un evento al MIT (secondo Wired). Un altro esempio è OPT-175B di Meta. Meta afferma che è stato addestrato utilizzando 992 GPU NVIDIA A100 da 80 GB, che costano circa 10.000 dollari per unità, secondo CNBC. Questo pone il costo a circa 9 milioni di dollari, senza includere altre spese come energia, stipendi e altro.

Con tali cifre, non è praticabile per le piccole e medie imprese addestrare un LLM. Al contrario, gli SLM hanno una barriera all’ingresso più bassa in termini di risorse e costano di meno da gestire, per questo più aziende li adotteranno.

2. Maggiore Prestazione

GBJSTOCK / Shutterstock

GBJSTOCK / Shutterstock

La prestazione è un’altra area in cui gli SLM superano gli LLM grazie alle loro dimensioni compatte. Gli SLM hanno una latenza inferiore e sono più adatti per scenari dove sono necessarie risposte più rapide, come nelle applicazioni in tempo reale. Ad esempio, una risposta più veloce è preferibile nei sistemi di risposta vocale come gli assistenti digitali.

Funzionare on-device (ne parleremo più avanti) significa anche che la tua richiesta non deve fare un viaggio verso i server online e tornare per rispondere alla tua domanda, portando a risposte più rapide.

3. Maggiore Accuratezza

ZinetroN / Shutterstock

ZinetroN / Shutterstock

Quando si tratta di AI generativa, una costante rimane: garbage in, garbage out. Gli attuali LLM sono stati addestrati utilizzando grandi dataset di dati grezzi provenienti da internet. Pertanto, potrebbero non essere accurati in tutte le situazioni. Questo è uno dei problemi con ChatGPT e modelli simili e il motivo per cui non dovresti fidarti di tutto ciò che dice un chatbot AI. D’altra parte, gli SLM sono addestrati utilizzando dati di qualità superiore rispetto agli LLM e quindi hanno un’accuratezza maggiore.

Inoltre, gli SLM possono essere ulteriormente ottimizzati con un addestramento focalizzato su compiti o domini specifici, portando a una migliore accuratezza in quelle aree rispetto a modelli più grandi e generalizzati.

4. Possono Funzionare On-Device

Pete Hansen/Shutterstock

Pete Hansen/Shutterstock

Gli SLM necessitano di meno potenza computazionale rispetto agli LLM e quindi sono ideali per casi di edge computing. Possono essere distribuiti su dispositivi edge come smartphone e veicoli autonomi, che non dispongono di grandi potenze computazionali o risorse. Il modello Nano di Google può funzionare on-device, consentendogli di operare anche quando non si ha una connessione internet attiva.

Questa capacità rappresenta una situazione win-win sia per le aziende che per i consumatori. Prima di tutto, è vantaggiosa per la privacy poiché i dati dell’utente vengono elaborati localmente anziché inviati al cloud, il che è importante in un’epoca in cui sempre più AI è integrata nei nostri smartphone, che contengono praticamente ogni dettaglio su di noi. È anche vincenti per le aziende, poiché non devono distribuire e gestire grandi server per gestire i compiti legati all’AI.

Gli SLM stanno guadagnando slancio, con i maggiori attori del settore, come Open AI, Google, Microsoft, Anthropic e Meta, che rilasciano tali modelli. Questi modelli sono più adatti per compiti più semplici, che è esattamente ciò per cui la maggior parte di noi utilizza gli LLM; quindi, rappresentano il futuro.

Tuttavia, gli LLM non spariranno. Al contrario, saranno utilizzati per applicazioni avanzate che combinano informazioni provenienti da diversi domini per creare qualcosa di nuovo, come nella ricerca medica.

In sintesi, i modelli di linguaggio di piccole dimensioni (SLM) stanno emergendo come una forza trainante nel futuro dell’AI. Con investimenti da parte di grandi aziende e un crescente interesse in tutto il settore, gli SLM rappresentano una soluzione più accessibile, veloce e precisa per una varietà di casi d’uso, rendendoli la scelta migliore per molte applicazioni quotidiane. Mentre i modelli di grandi dimensioni (LLM) continueranno ad avere il loro posto per compiti complessi, gli SLM stanno cambiando il panorama e promettono di essere al centro dell’evoluzione dell’AI per il futuro.