I bias algoritmici possono avere un impatto su vari aspetti della nostra vita, dall’ottenimento di consigli sui contenuti online alla ricerca di lavoro e alle decisioni finanziarie.

I pregiudizi sono nella natura umana. Persone diverse hanno generi, razze, educazione, background formativi, culture, credenze, esperienze diverse e così via.

Pertanto, le loro opinioni, pensieri, simpatie e antipatie e preferenze variano l’uno dall’altro. Possono sviluppare determinati pregiudizi verso o contro determinate categorie.

Le macchine non sono diverse. Questi potrebbero anche vedere persone, cose ed eventi in modo diverso a causa dei pregiudizi introdotti nei loro algoritmi. A causa di questi pregiudizi, i sistemi di intelligenza artificiale e machine learning possono produrre risultati ingiusti, ostacolando le persone in molti modi.

In questo articolo discuterò cosa sono i bias algoritmici, i loro tipi e come rilevarli e ridurli al fine di migliorare l’equità dei risultati.

Cominciamo!

Sommario:

Cosa sono i bias algoritmici?

Un bias algoritmico è la tendenza degli algoritmi ML e AI a riflettere pregiudizi di tipo umano e generare risultati ingiusti. I pregiudizi potrebbero essere basati su genere, età, razza, religione, etnia, cultura e così via.

Nel contesto dell’intelligenza artificiale e dell’apprendimento automatico, i bias algoritmici sono errori sistematici e ripetibili introdotti in un sistema che producono risultati ingiusti.

I pregiudizi negli algoritmi possono sorgere per molte ragioni, come le decisioni relative al modo in cui i dati vengono raccolti, scelti, codificati o utilizzati nell’addestramento dell’algoritmo, l’uso previsto, la progettazione dell’algoritmo, ecc.

Esempio: puoi osservare distorsioni algoritmiche nei risultati di un motore di ricerca, che portano a violazioni della privacy, pregiudizi sociali, ecc.

Esistono molti casi di pregiudizi algoritmici in aree quali i risultati elettorali, la diffusione dell’incitamento all’odio online, l’assistenza sanitaria, la giustizia penale, il reclutamento, ecc. Ciò sta aggravando i pregiudizi esistenti in termini di genere, razza, economia e società.

Tipi di bias algoritmici

#1. Distorsione dei dati

La distorsione dei dati si verifica quando i dati richiesti per l’addestramento di un modello di intelligenza artificiale non rappresentano adeguatamente scenari o popolazioni del mondo reale. Ciò potrebbe comportare set di dati sbilanciati o distorti.

Fonte: TELUS Internazionale

Fonte: TELUS Internazionale

Esempio: supponiamo che una soluzione software di riconoscimento facciale sia adattata principalmente alla popolazione bianca. Pertanto, potrebbe funzionare male quando viene incaricato di riconoscere le persone con tonalità della pelle più scure, influenzandole.

#2. Distorsione dalla misurazione

Questo bias può verificarsi a causa di un errore nel processo di misurazione o raccolta dei dati.

Esempio: se addestri un algoritmo diagnostico sanitario per rilevare una malattia sulla base di alcuni parametri come le precedenti visite mediche, potrebbe offuscare la capacità di giudizio e causare pregiudizi trascurando i sintomi reali.

#3. Bias del modello

I bias del modello sorgono durante la progettazione dell’algoritmo o del modello di intelligenza artificiale.

Esempio: supponiamo che un sistema di intelligenza artificiale abbia un algoritmo progettato per massimizzare i profitti, non importa come; potrebbe finire per dare priorità ai guadagni finanziari a scapito dell’etica aziendale, della sicurezza, dell’equità, ecc.

#4. Bias di valutazione

Gli errori di valutazione possono verificarsi quando i fattori o i criteri per valutare le prestazioni di un sistema di intelligenza artificiale sono distorti.

Fonte: Recensione chiara

Fonte: Recensione chiara

Esempio: se un sistema di intelligenza artificiale per la valutazione delle prestazioni utilizza test standard che favoriscono una categoria specifica di dipendenti in un’azienda, può promuovere le disuguaglianze.

#5. Distorsioni nei rapporti

Possono verificarsi errori di reporting quando il set di dati di addestramento non riflette accuratamente la realtà nella frequenza degli eventi.

Esempio: se uno strumento di sicurezza AI non funziona bene in una categoria specifica, potrebbe contrassegnare l’intera categoria come sospetta.

Ciò significa che il set di dati su cui è stato addestrato il sistema ha contrassegnato ogni incidente storico relativo a quella categoria come non sicuro a causa della maggiore frequenza degli incidenti.

#6. Bias di selezione

Si verificano errori di selezione quando i dati di addestramento vengono selezionati senza un’adeguata randomizzazione o non rappresentano bene la popolazione totale.

Esempio: se uno strumento di riconoscimento facciale viene addestrato su dati limitati, potrebbe iniziare a mostrare una certa discriminazione nei confronti dei dati che incontra meno, come l’identificazione delle donne di colore in politica rispetto a quella dei maschi e degli individui dalla pelle più chiara in politica.

#7. Bias implicito

I pregiudizi impliciti si verificano quando l’algoritmo dell’intelligenza artificiale formula ipotesi basate su determinate esperienze personali, che potrebbero non applicarsi esplicitamente a categorie o persone più ampie.

Esempio: se uno scienziato dei dati che progetta un algoritmo di intelligenza artificiale ritiene personalmente che alle donne piaccia principalmente il rosa e non il blu o il nero, il sistema potrebbe consigliare i prodotti di conseguenza, il che non si applica a tutte le donne. Molti amano il blu o il nero.

#8. Distorsione da attribuzione di gruppo

Questo pregiudizio può verificarsi quando i progettisti dell’algoritmo applicano cose destinate a determinati individui a un gruppo completo, indipendentemente dal fatto che tali individui facciano parte del gruppo o meno. Il bias di attribuzione di gruppo è comune negli strumenti di reclutamento e ammissione.

Esempio: uno strumento di ammissione può favorire i candidati di una scuola specifica, discriminando altri studenti che non appartengono a quella scuola.

#9. Pregiudizio storico

La raccolta di set di dati storici è importante quando si raccolgono set di dati per l’addestramento di un algoritmo ML. Ma se non presti attenzione, possono verificarsi distorsioni nei tuoi algoritmi a causa delle distorsioni presenti nei tuoi dati storici.

Esempio: se addestri un modello di intelligenza artificiale con 10 anni di dati storici per selezionare i candidati per posizioni tecniche, potresti favorire i candidati di sesso maschile se i dati di addestramento contengono più uomini che donne.

#10. Bias dell’etichetta

Durante l’addestramento degli algoritmi ML, potrebbe essere necessario etichettare molti dati per renderli utili. Tuttavia, il processo di etichettatura dei dati potrebbe variare molto, generando incoerenze e introducendo distorsioni nel sistema di intelligenza artificiale.

Esempio: supponiamo di addestrare un algoritmo di intelligenza artificiale etichettando i gatti nelle immagini utilizzando le scatole. Se non presti attenzione, l’algoritmo potrebbe non riuscire a identificare un gatto in una foto se la sua faccia non è visibile, ma può identificare quelli con facce di gatto sopra.

Ciò significa che l’algoritmo è parziale nell’identificare le immagini con gatti rivolti in avanti. Non è possibile identificare il gatto se l’immagine viene scattata da un’angolazione diversa quando si vede il corpo ma non il viso.

#11. Bias di esclusione

Fonte: Sportello di ricerca

Fonte: Sportello di ricerca

Il bias di esclusione si verifica quando una persona specifica, un gruppo di persone o una categoria vengono esclusi involontariamente o intenzionalmente durante la raccolta dei dati se ritenuti irrilevanti. Avviene principalmente durante la fase di preparazione dei dati del ciclo di vita ML, al momento della pulizia dei dati e della loro preparazione per l’uso.

Esempio: supponiamo che un sistema di previsione basato sull’intelligenza artificiale debba determinare la popolarità di un prodotto specifico durante la stagione invernale in base al suo tasso di acquisto. Pertanto, se un data scientist nota alcuni acquisti in ottobre e rimuove tali record, ritenendo che siano errati e considerando la durata standard da novembre a gennaio. Ma ci sono luoghi in cui l’inverno supera quei mesi. Pertanto, l’algoritmo sarà sbilanciato verso i paesi che ricevono l’inverno da novembre a gennaio.

Come vengono introdotti i bias negli algoritmi?

Dati di allenamento

La principale fonte di bias algoritmico sono i dati distorti utilizzati per l’addestramento degli algoritmi AI e ML. Se i dati di addestramento stessi contengono elementi di disuguaglianze e pregiudizi, l’algoritmo apprenderà quegli elementi e perpetuerà i pregiudizi.

Progetto

Durante la progettazione dell’algoritmo, lo sviluppatore potrebbe, consapevolmente o inconsapevolmente, introdurre riflessioni su pensieri o preferenze personali nel sistema di intelligenza artificiale. Pertanto, il sistema di intelligenza artificiale sarà sbilanciato verso determinate categorie.

Il processo decisionale

Molte volte, i data scientist e i leader prendono decisioni in base alle proprie esperienze personali, all’ambiente circostante, alle convinzioni e così via. Queste decisioni si riflettono anche negli algoritmi, il che causa pregiudizi.

Mancanza di diversità

A causa della mancanza di diversità nel team di sviluppo, i membri del team finiscono per creare algoritmi che non rappresentano l’intera popolazione. Non hanno esperienza o esposizione ad altre culture, background, credenze, modi, ecc., motivo per cui i loro algoritmi possono essere distorti in un certo modo.

Preelaborazione dei dati

Il metodo utilizzato per la pulizia e l’elaborazione dei dati può introdurre distorsioni algoritmiche. Inoltre, se non si progettano attentamente questi metodi per contrastare i pregiudizi, la situazione potrebbe peggiorare nel modello di intelligenza artificiale.

Architettura

Anche l’architettura del modello e il tipo di algoritmo ML scelti possono introdurre distorsioni. Alcuni algoritmi attirano pregiudizi più di altri, insieme al modo in cui sono progettati.

Selezione delle funzionalità

Le funzionalità scelte per addestrare un algoritmo AI sono una delle cause di bias. Se non si scelgono le caratteristiche tenendo conto del loro impatto sull’equità dell’output, possono sorgere alcuni pregiudizi, che favoriscono alcune categorie.

Storia e Cultura

Se un algoritmo viene alimentato e addestrato su dati presi dalla storia o da determinate culture, può ereditare pregiudizi come pregiudizi, credenze, norme, ecc. Questi pregiudizi possono avere un impatto sui risultati dell’intelligenza artificiale anche se sono ingiusti e irrilevanti nel presente.

Deriva dei dati

I dati che utilizzi oggi per addestrare i tuoi algoritmi di intelligenza artificiale potrebbero diventare irrilevanti, inutili o obsoleti in futuro. Ciò potrebbe essere dovuto al cambiamento della tecnologia o della società. Tuttavia, questi set di dati possono ancora introdurre distorsioni e ostacolare le prestazioni.

Anelli di retroazione

Alcuni sistemi di intelligenza artificiale non solo possono comunicare con gli utenti ma anche adattarsi ai loro comportamenti. In questo modo, l’algoritmo può aumentare i pregiudizi esistenti. Pertanto, quando i pregiudizi personali degli utenti entrano nel sistema di intelligenza artificiale, può generare un ciclo di feedback distorto.

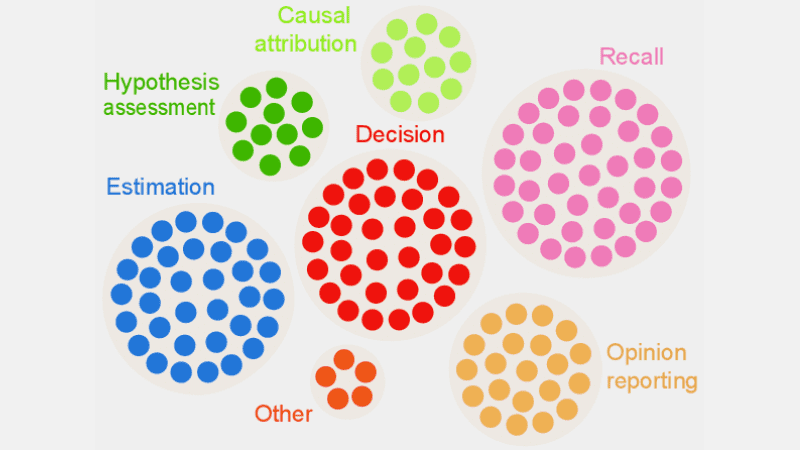

Come rilevare i bias algoritmici?

Definire cosa è “giusto”

Per rilevare risultati ingiusti o pregiudizi negli algoritmi, è necessario definire cosa implica esattamente “giusto” per il sistema di intelligenza artificiale. Per questo, puoi considerare fattori come sesso, età, razza, sessualità, regione, cultura, ecc.

Determinare i parametri per calcolare l’equità, come pari opportunità, parità predittiva, impatti, ecc. Una volta definita l’equità, diventa più facile per te individuare ciò che non è giusto e risolvere la situazione.

Controllare i dati di formazione

Analizza attentamente i tuoi dati di allenamento per cercare squilibri e incoerenze nella rappresentazione di diverse categorie. È necessario esaminare la distribuzione delle funzionalità e verificare se rappresenta i dati demografici del mondo reale o meno.

Per visualizzare i dati, puoi creare istogrammi, mappe di calore, grafici a dispersione, ecc. per evidenziare disparità e modelli che non possono essere rivelati con l’aiuto della sola analisi statistica.

Oltre agli audit interni, è possibile coinvolgere esperti e revisori esterni per valutare le distorsioni del sistema.

Misurare le prestazioni del modello

Per rilevare i pregiudizi, prova a misurare le prestazioni del tuo modello di intelligenza artificiale per vari dati demografici e categorie. Sarebbe utile dividere la formazione in diversi gruppi in base a razza, sesso, ecc. Puoi anche utilizzare le tue metriche di equità per calcolare le differenze nei risultati.

Utilizzare algoritmi adatti

Scegli algoritmi che promuovano risultati equi e possano affrontare i pregiudizi nell’addestramento di un modello di intelligenza artificiale. Gli algoritmi consapevoli dell’equità mirano a prevenire distorsioni garantendo al contempo previsioni uguali tra le varie categorie.

Software per il rilevamento dei bias

È possibile utilizzare strumenti e librerie specializzati che tengano conto dell’equità per rilevare i bias. Questi strumenti offrono metriche di equità, visualizzazioni, test statistici e altro ancora per rilevare bias. Alcuni popolari sono AI Fairness 360 e IBM Fairness 360.

Cerca il feedback degli utenti

Chiedi a utenti e clienti il loro feedback sul sistema di intelligenza artificiale. Incoraggiali a fornire le loro recensioni oneste se hanno avvertito qualsiasi tipo di trattamento ingiusto o pregiudizio nel sistema di intelligenza artificiale. Questi dati ti aiuteranno a individuare i problemi che potrebbero non essere segnalati negli strumenti automatizzati e in altre procedure di rilevamento.

Come mitigare i bias negli algoritmi

Diversifica la tua azienda

Creare diversità nella tua azienda e nel team di sviluppo consente di individuare e rimuovere più rapidamente i pregiudizi. Il motivo è che i pregiudizi possono essere notati rapidamente dagli utenti che ne sono colpiti.

Quindi, diversifica la tua azienda non solo in termini demografici ma anche in competenze e competenze. Includere persone di sesso, identità, razza, colore della pelle, background economico, ecc. diversi, nonché persone con esperienze educative e background diversi.

In questo modo, raccoglierai prospettive, esperienze, valori culturali, simpatie e antipatie di ampio respiro, ecc. Ciò ti aiuterà a migliorare l’equità dei tuoi algoritmi di intelligenza artificiale, riducendo i pregiudizi.

Promuovere la trasparenza

Sii trasparente con il tuo team riguardo all’obiettivo, agli algoritmi, alle origini dati e alle decisioni riguardanti un sistema di intelligenza artificiale. Ciò consentirà agli utenti di comprendere come funziona il sistema di intelligenza artificiale e perché genera determinati risultati. Questa trasparenza favorirà la fiducia.

Algoritmi consapevoli dell’equità

Utilizzare algoritmi consapevoli dell’equità durante lo sviluppo del modello per garantire che vengano generati risultati equi per le diverse categorie. Ciò diventa evidente se si creano sistemi di intelligenza artificiale per settori altamente regolamentati come la finanza, la sanità, ecc.

Valutare le prestazioni del modello

Metti alla prova i tuoi modelli per esaminare le prestazioni dell’intelligenza artificiale in vari gruppi e sottogruppi. Ti aiuterà a comprendere i problemi che non sono visibili nelle metriche aggregate. Puoi anche simulare diversi scenari per verificarne le prestazioni in tali scenari, compresi quelli complessi.

Seguire le linee guida etiche

Formulare alcune linee guida etiche per lo sviluppo di sistemi di IA, nel rispetto dell’equità, della privacy, della sicurezza e dei diritti umani. È necessario applicare tali linee guida a tutta l’organizzazione in modo che l’equità aumenti a livello di organizzazione e si rifletta nei risultati del sistema di intelligenza artificiale.

Imposta controlli e responsabilità

Definire responsabilità chiare per tutti i membri del team che lavorano alla progettazione, allo sviluppo, alla manutenzione e all’implementazione del sistema di intelligenza artificiale. È inoltre necessario impostare controlli adeguati con protocolli e framework rigorosi per affrontare pregiudizi, errori e altre preoccupazioni.

Oltre a quanto sopra, è necessario effettuare controlli regolari per ridurre i pregiudizi e puntare a miglioramenti continui. Inoltre, rimani aggiornato sui recenti cambiamenti tecnologici, demografici e altri fattori.

Esempi reali di bias algoritmici

#1. L’algoritmo di Amazon

Amazon è leader nel settore dell’e-commerce. Tuttavia, è strumento di reclutamento che hanno utilizzato l’intelligenza artificiale per valutare i candidati in base alle loro qualifiche hanno mostrato pregiudizi di genere. Questo sistema di intelligenza artificiale è stato formato utilizzando i curriculum dei precedenti candidati nei ruoli tecnici.

Sfortunatamente, i dati contenevano un numero maggiore di candidati uomini, come ha appreso l’IA. Pertanto, ha involontariamente favorito i candidati uomini in ruoli tecnici rispetto alle donne che erano sottorappresentate. Amazon ha dovuto interrompere lo strumento nel 2017 nonostante gli sforzi compiuti per ridurre la distorsione.

#2. Algoritmi razzisti nel sistema sanitario statunitense

Un algoritmo utilizzato dagli ospedali statunitensi per prevedere i pazienti che necessitano di cure aggiuntive era pesantemente utilizzato sbilanciato nei confronti dei pazienti bianchi. Il sistema valutava le esigenze mediche dei pazienti in base alla cronologia delle spese sanitarie, correlando i costi con le esigenze mediche.

L’algoritmo del sistema non ha considerato il modo in cui i pazienti bianchi e neri pagavano per le loro esigenze sanitarie. Nonostante la malattia incontrollata, i pazienti neri pagavano principalmente per le emergenze. Pertanto, sono stati classificati come pazienti più sani e non avevano diritto a cure aggiuntive rispetto ai pazienti bianchi.

#3. L’algoritmo discriminante di Google

È stato trovato il sistema di annunci online di Google discriminante. Ha mostrato posizioni ben retribuite come quelle di amministratore delegato per i maschi significativamente più grandi delle donne. Anche se il 27% degli amministratori delegati statunitensi sono donne, la loro rappresentanza è molto più ridotta in Google, intorno all’11%.

L’algoritmo avrebbe potuto mostrare l’output apprendendo il comportamento degli utenti, ad esempio le persone che visualizzano e fanno clic sugli annunci per ruoli ben pagati sono uomini; l’algoritmo AI mostrerà quegli annunci più agli uomini che alle donne.

Conclusione

I bias algoritmici nei sistemi ML e AI possono portare a risultati ingiusti. Questi risultati possono avere un impatto sugli individui in vari campi, dalla sanità, alla sicurezza informatica, all’e-commerce, alle elezioni, all’occupazione e altro ancora. Può portare alla discriminazione sulla base del genere, della razza, dei dati demografici, dell’orientamento sessuale e di altri aspetti.

Pertanto, è importante ridurre i pregiudizi negli algoritmi di intelligenza artificiale e machine learning per promuovere l’equità dei risultati. Le informazioni di cui sopra ti aiuteranno a rilevare i pregiudizi e a ridurli in modo da poter creare sistemi di intelligenza artificiale equi per gli utenti.

Puoi anche leggere informazioni sulla governance dell’IA.