Ti stai chiedendo come ottenere dati affidabili e coerenti per l’analisi dei dati? Implementa subito queste strategie di pulizia dei dati!

La tua decisione aziendale si basa sugli approfondimenti dell’analisi dei dati. Analogamente, le informazioni ricavate dai set di dati di input si basano sulla qualità dei dati di origine. Origini dati di bassa qualità, imprecise, spazzatura e incoerenti sono le sfide difficili per il settore della scienza dei dati e dell’analisi dei dati.

Pertanto, gli esperti hanno escogitato soluzioni alternative. Questa soluzione è la pulizia dei dati. Ti evita di prendere decisioni basate sui dati che danneggeranno l’azienda invece di migliorarla.

Continua a leggere per apprendere le migliori strategie di pulizia dei dati utilizzate da data scientist e analisti di successo. Inoltre, esplora strumenti in grado di offrire dati puliti per progetti di data science istantanei.

Sommario:

Cos’è la pulizia dei dati?

La qualità dei dati ha cinque dimensioni. L’identificazione e la correzione degli errori nei dati di input seguendo le politiche sulla qualità dei dati è nota come pulizia dei dati.

I parametri di qualità di questo standard a cinque dimensioni sono:

#1. Completezza

Questo parametro di controllo della qualità garantisce che i dati di input dispongano di tutti i parametri richiesti, intestazioni, righe, colonne, tabelle e così via, per un progetto di data science.

#2. Precisione

Un indicatore di qualità dei dati che indica che i dati sono vicini al vero valore dei dati di input. I dati possono essere di vero valore quando si seguono tutti gli standard statistici per i sondaggi o si scartano per la raccolta dei dati.

#3. Validità

Questo parametro data science indica che i dati sono conformi alle regole aziendali che hai impostato.

#4. Uniformità

L’uniformità conferma se i dati contengono contenuti uniformi o meno. Ad esempio, i dati dell’indagine sul consumo energetico negli Stati Uniti dovrebbero contenere tutte le unità come sistema di misurazione imperiale. Se utilizzi il sistema metrico per determinati contenuti nello stesso sondaggio, i dati non sono uniformi.

#5. Consistenza

La coerenza garantisce che i valori dei dati siano coerenti tra tabelle, modelli di dati e set di dati. È inoltre necessario monitorare attentamente questo parametro durante lo spostamento dei dati tra i sistemi.

In poche parole, applica i processi di controllo della qualità di cui sopra ai set di dati grezzi e pulisci i dati prima di inviarli a uno strumento di business intelligence.

Importanza della pulizia dei dati

Proprio così, non puoi gestire la tua attività digitale con un piano di larghezza di banda Internet scadente; non puoi prendere grandi decisioni quando la qualità dei dati è inaccettabile. Se provi a utilizzare dati spazzatura e errati per prendere decisioni aziendali, vedrai una perdita di entrate o uno scarso ritorno sull’investimento (ROI).

Secondo un report di Gartner sulla scarsa qualità dei dati e le sue conseguenze, il think tank ha scoperto che la perdita media che un’azienda deve affrontare è di 12,9 milioni di dollari. Questo è solo per prendere decisioni basandosi su dati errati, falsificati e spazzatura.

Lo stesso rapporto suggerisce che l’utilizzo di dati errati negli Stati Uniti costa al paese un’incredibile perdita annuale di 3 trilioni di dollari.

L’intuizione finale sarà sicuramente spazzatura se si alimenta il sistema BI con dati spazzatura.

Pertanto, è necessario ripulire i dati grezzi per evitare perdite monetarie e prendere decisioni aziendali efficaci dai progetti di analisi dei dati.

Vantaggi della pulizia dei dati

#1. Evitare perdite monetarie

Ripulendo i dati di input, puoi salvare la tua azienda da perdite monetarie che potrebbero comportare una sanzione per non conformità o perdita di clienti.

#2. Prendi grandi decisioni

I dati di alta qualità e fruibili offrono grandi insight. Tali approfondimenti ti aiutano a prendere decisioni aziendali eccezionali in merito al marketing del prodotto, alle vendite, alla gestione dell’inventario, ai prezzi, ecc.

#3. Ottieni un vantaggio sul concorrente

Se opti per la pulizia dei dati prima dei tuoi concorrenti, godrai dei vantaggi di diventare un motore veloce nel tuo settore.

#4. Rendi il progetto efficiente

Un processo di pulizia dei dati semplificato aumenta il livello di fiducia dei membri del team. Poiché sanno che i dati sono affidabili, possono concentrarsi maggiormente sull’analisi dei dati.

#5. Risparmia risorse

La pulizia e il taglio dei dati riduce le dimensioni del database complessivo. Pertanto, si cancella lo spazio di archiviazione del database eliminando i dati spazzatura.

Strategie per pulire i dati

Standardizza i dati visivi

Un set di dati conterrà numerosi tipi di caratteri come testi, cifre, simboli, ecc. È necessario applicare un formato uniforme di capitalizzazione del testo a tutti i testi. Assicurati che i simboli siano nella codifica corretta, come Unicode, ASCII, ecc.

Ad esempio, il termine in maiuscolo Bill indica il nome di una persona. Al contrario, una cambiale o cambiale significa una ricevuta di una transazione; quindi, la formattazione appropriata delle maiuscole è fondamentale.

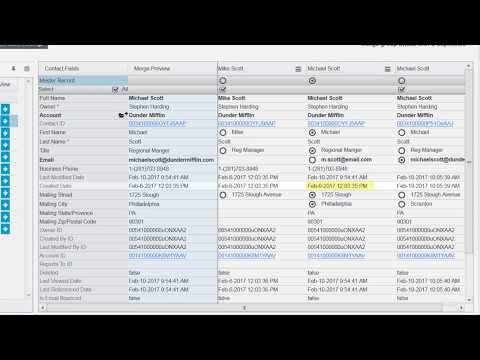

Rimuovi i dati replicati

I dati duplicati confondono il sistema BI. Di conseguenza, il modello risulterà distorto. Pertanto, è necessario eliminare le voci duplicate dal database di input.

I duplicati di solito provengono da processi di immissione dati umani. Se puoi automatizzare il processo di immissione dei dati non elaborati, puoi eliminare le repliche dei dati dalla radice.

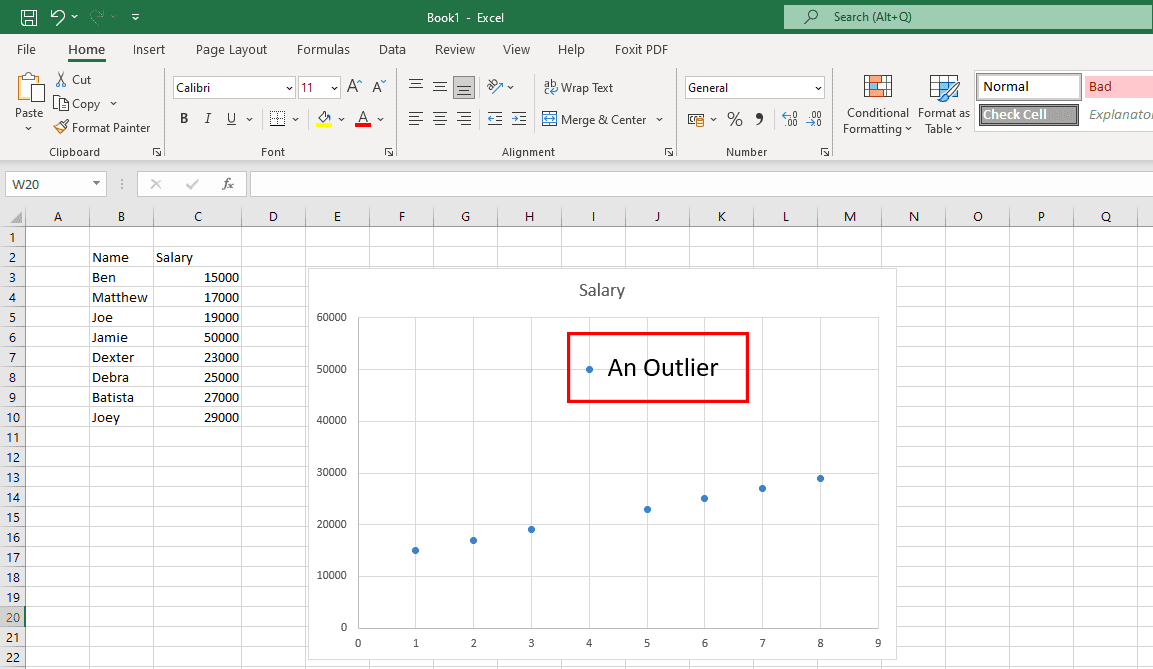

Correggi i valori anomali indesiderati

I valori anomali sono punti dati insoliti che non si trovano all’interno del modello di dati, come mostrato nel grafico sopra. I valori anomali autentici vanno bene poiché aiutano i data scientist a scoprire i difetti del sondaggio. Tuttavia, se i valori anomali provengono da errori umani, allora è un problema.

È necessario inserire i set di dati in tabelle o grafici per cercare valori anomali. Se ne trovi qualcuno, indaga sulla fonte. Se la fonte è un errore umano, rimuovi i dati anomali.

Focus sui dati strutturali

Si tratta principalmente di trovare e correggere errori nei set di dati.

Ad esempio, un set di dati contiene una colonna di USD e molte colonne di altre valute. Se i tuoi dati sono per il pubblico statunitense, converti le altre valute in USD equivalenti. Quindi, sostituisci tutte le altre valute in USD.

Scansiona i tuoi dati

Un enorme database scaricato da un data warehouse può contenere migliaia di tabelle. Potresti non aver bisogno di tutte le tabelle per il tuo progetto di data science.

Quindi, dopo aver ottenuto il database, è necessario scrivere uno script per individuare le tabelle di dati necessarie. Una volta che lo sai, puoi eliminare le tabelle irrilevanti e ridurre al minimo le dimensioni del set di dati.

Ciò si tradurrà in ultima analisi in una scoperta più rapida dei modelli di dati.

Pulisci i dati sul cloud

Se il tuo database utilizza l’approccio schema-on-write, devi convertirlo in schema-on-read. Ciò consentirà la pulizia dei dati direttamente sul cloud storage e l’estrazione di dati formattati, organizzati e pronti per l’analisi.

Tradurre lingue straniere

Se esegui un sondaggio in tutto il mondo, puoi aspettarti lingue straniere nei dati grezzi. Devi tradurre righe e colonne contenenti lingue straniere in inglese o in qualsiasi altra lingua tu preferisca. A tale scopo è possibile utilizzare gli strumenti di traduzione assistita da computer (CAT).

Pulizia dei dati passo dopo passo

#1. Individua campi dati critici

Un data warehouse contiene terabyte di database. Ogni database può contenere da poche a migliaia di colonne di dati. Ora, è necessario esaminare l’obiettivo del progetto ed estrarre i dati da tali database di conseguenza.

Se il tuo progetto studia le tendenze di acquisto e-commerce dei residenti negli Stati Uniti, la raccolta di dati sui negozi al dettaglio offline nella stessa cartella di lavoro non servirà a nulla.

#2. Organizza i dati

Dopo aver individuato i campi dati importanti, le intestazioni di colonna, le tabelle, ecc., da un database, fascicolarli in modo organizzato.

#3. Elimina i duplicati

I dati grezzi raccolti dai data warehouse conterranno sempre voci duplicate. È necessario individuare ed eliminare tali repliche.

#4. Elimina valori e spazi vuoti

Alcune intestazioni di colonna e il campo dati corrispondente potrebbero non contenere valori. È necessario eliminare quelle intestazioni/campi di colonna o sostituire i valori vuoti con quelli alfanumerici corretti.

#5. Eseguire la formattazione fine

I set di dati possono contenere spazi, simboli, caratteri e così via non necessari. È necessario formattarli utilizzando formule in modo che il set di dati complessivo appaia uniforme in termini di dimensioni e estensione della cella.

#6. Standardizzare il processo

È necessario creare una SOP che i membri del team di data science possano seguire e svolgere il proprio dovere durante il processo di pulizia dei dati. Deve includere quanto segue:

- Frequenza della raccolta dei dati grezzi

- Responsabile dell’archiviazione e della manutenzione dei dati grezzi

- Frequenza di pulizia

- Supervisore dell’archiviazione e della manutenzione dei dati puliti

Ecco alcuni popolari strumenti di pulizia dei dati che possono aiutarti nei tuoi progetti di data science:

WinPure

Se stai cercando un’applicazione che ti consenta di pulire e ripulire i dati in modo accurato e rapido, WinPure è una soluzione affidabile. Questo strumento leader del settore offre una struttura di pulizia dei dati a livello aziendale con velocità e precisione senza pari.

Poiché è progettato per servire singoli utenti e aziende, chiunque può utilizzarlo senza difficoltà. Il software utilizza la funzione Advanced Data Profiling per analizzare tipi, formati, integrità e valore dei dati per il controllo della qualità. Il suo potente e intelligente motore di corrispondenza dei dati sceglie le corrispondenze perfette con il minimo di false corrispondenze.

Oltre alle funzionalità di cui sopra, WinPure offre anche immagini straordinarie per tutti i dati, le partite di gruppo e le non partite.

Funziona anche come strumento di fusione che unisce i record duplicati per generare un record principale in grado di conservare tutti i valori correnti. Inoltre, puoi utilizzare questo strumento per definire le regole per la selezione dei record master e rimuovere tutti i record all’istante.

ApriAffina

OpenRefine è uno strumento gratuito e open source che ti aiuta a trasformare i tuoi dati disordinati in un formato pulito che può essere utilizzato per i servizi web. Utilizza i facet per pulire set di dati di grandi dimensioni e opera su viste di set di dati filtrate.

Con l’aiuto di potenti euristiche, lo strumento può unire valori simili per eliminare tutte le incoerenze. Offre servizi di riconciliazione in modo che gli utenti possano abbinare i propri set di dati a database esterni. Inoltre, l’utilizzo di questo strumento significa che è possibile tornare alla versione precedente del set di dati, se necessario.

Inoltre, gli utenti possono riprodurre la cronologia delle operazioni su una versione aggiornata. Se sei preoccupato per la sicurezza dei dati, OpenRefine è l’opzione giusta per te. Pulisce i tuoi dati sulla tua macchina, quindi non c’è migrazione dei dati al cloud per questo scopo.

Trifacta Designer Cloud

Anche se la pulizia dei dati può essere complessa, Trifacta Designer Cloud ti semplifica le cose. Utilizza un nuovo approccio di preparazione dei dati per il lavaggio dei dati in modo che le organizzazioni possano trarne il massimo valore.

La sua interfaccia user-friendly consente agli utenti non tecnici di pulire e ripulire i dati per analisi sofisticate. Ora le aziende possono fare di più con i propri dati sfruttando i suggerimenti intelligenti basati su ML di Trifacta Designer Cloud.

Inoltre, dovranno investire meno tempo in questo processo pur dovendo affrontare un minor numero di errori. Richiede di utilizzare risorse ridotte per ottenere di più dall’analisi.

Cloudingo

Sei un utente Salesforce preoccupato per la qualità dei dati raccolti? Usa Cloudingo per ripulire i dati dei clienti e avere solo i dati necessari. Questa applicazione semplifica la gestione dei dati dei clienti con funzionalità come la deduplicazione, l’importazione e la migrazione.

Qui puoi controllare l’unione dei record con filtri e regole personalizzabili e standardizzare i dati. Elimina i dati inutili e inattivi, aggiorna i punti dati mancanti e garantisci la precisione negli indirizzi postali statunitensi.

Inoltre, le aziende possono programmare Cloudingo per deduplicare automaticamente i dati in modo da avere sempre accesso a dati puliti. Mantenere i dati sincronizzati con Salesforce è un’altra caratteristica cruciale di questo strumento. Con esso, puoi persino confrontare i dati di Salesforce con le informazioni memorizzate in un foglio di calcolo.

ZoomInfo

ZoomInfo è un fornitore di soluzioni per la pulizia dei dati che contribuisce alla produttività e all’efficacia del tuo team. Le aziende possono sperimentare una maggiore redditività in quanto questo software fornisce dati senza duplicazioni al CRM e ai MAT aziendali.

Semplifica la gestione della qualità dei dati rimuovendo tutti i costosi dati duplicati. Gli utenti possono anche proteggere il proprio perimetro CRM e MAT utilizzando ZoomInfo. Può ripulire i dati in pochi minuti con deduplicazione, corrispondenza e normalizzazione automatiche.

Gli utenti di questa applicazione possono godere della flessibilità e del controllo sui criteri di corrispondenza e sui risultati uniti. Ti aiuta a creare un sistema di archiviazione dei dati conveniente standardizzando qualsiasi tipo di dati.

Parole finali

Dovresti essere preoccupato per la qualità dei dati di input nei tuoi progetti di data science. È il feed di base per grandi progetti come l’apprendimento automatico (ML), le reti neurali per l’automazione basata sull’intelligenza artificiale, ecc. Se il feed è difettoso, pensa a quale sarebbe il risultato di tali progetti.

Pertanto, la tua organizzazione deve adottare una comprovata strategia di pulizia dei dati e implementarla come procedura operativa standard (SOP). Di conseguenza, migliorerà anche la qualità dei dati di input.

Se sei abbastanza impegnato con progetti, marketing e vendite, è meglio lasciare la parte di pulizia dei dati agli esperti. L’esperto potrebbe essere uno qualsiasi degli strumenti di pulizia dei dati di cui sopra.

Potresti anche essere interessato a un diagramma del progetto di servizio per implementare strategie di pulizia dei dati senza sforzo.