Con l’arrivo di tecnologie emergenti come deep learning, AI e ML, le GPU cloud sono molto richieste.

Se la tua organizzazione si occupa di visualizzazioni 3D, apprendimento automatico (ML), intelligenza artificiale (AI) o elaborazione pesante di qualche tipo, il modo in cui esegui il calcolo della GPU è molto importante.

Tradizionalmente, i modelli di deep learning nelle organizzazioni richiedevano molto tempo per le attività di formazione e calcolo. Di solito ammazzava il loro tempo, costava loro molto e lasciava loro problemi di spazio e archiviazione, riducendo la produttività.

Le GPU new age sono progettate per risolvere questo problema. Offrono un’elevata efficienza per eseguire calcoli pesanti e un addestramento più rapido per i tuoi modelli di intelligenza artificiale in parallelo.

Secondo la ricerca Indigo, le GPU possono offrire 250 volte più veloce prestazioni rispetto alle CPU durante l’addestramento delle reti neurali associate al deep learning.

E con il progresso del cloud computing, ora disponiamo di GPU cloud che stanno trasformando il mondo della scienza dei dati e di altre tecnologie emergenti offrendo prestazioni ancora più veloci, facile manutenzione, costi ridotti, scalabilità rapida e risparmio di tempo.

Questo articolo ti introdurrà ai concetti della GPU cloud, alla relazione con AI, ML, deep learning e alcune delle migliori piattaforme GPU cloud che puoi trovare per distribuire la tua GPU cloud preferita.

Cominciamo!

Sommario:

Che cos’è una GPU cloud?

Per comprendere una GPU cloud, parliamo prima di tutto delle GPU.

Un’unità di elaborazione grafica (GPU) si riferisce a un circuito elettronico specializzato utilizzato per alterare e manipolare rapidamente la memoria per accelerare la creazione di immagini o grafica.

Le moderne GPU offrono una maggiore efficienza nella manipolazione dell’elaborazione delle immagini e della computer grafica grazie alla loro struttura parallela rispetto alle Central Processing Unit (CPU). Una GPU è incorporata sulla sua scheda madre o posizionata sulla scheda video di un PC o sul die della CPU.

Le unità grafiche cloud (GPU) sono istanze di computer con una robusta accelerazione hardware utili per eseguire applicazioni per gestire enormi carichi di lavoro di intelligenza artificiale e deep learning nel cloud. Non è necessario che tu distribuisca una GPU fisica sul tuo dispositivo.

Alcune GPU popolari sono NVIDIA, AMD, Radeon, GeForce e altre.

Le GPU sono utilizzate in:

- Cellulari

- Console di gioco

- Postazioni di lavoro

- Sistemi integrati

- Computer personale

A cosa servono le GPU:

Ecco alcuni casi d’uso delle GPU:

- In AI e ML per il riconoscimento delle immagini

- Calcoli per computer grafica 3D e disegni CAD

- Mappatura delle texture e rendering dei poligoni

- Calcoli geometrici come traslazioni e rotazioni di vertici in sistemi di coordinate

- Supporto di shader programmabili per manipolare trame e vertici

- Codifica, decodifica e streaming video con accelerazione GPU

- Giochi ricchi di grafica e giochi su cloud

- Modellazione matematica, analisi e deep learning su larga scala che richiedono capacità di elaborazione parallela di GPU generiche.

- Montaggio video, progettazione grafica e creazione di contenuti

Quali sono i vantaggi delle GPU cloud? 👍

I principali vantaggi dell’utilizzo delle GPU Cloud sono:

Altamente scalabile

Se desideri espandere la tua organizzazione, il suo carico di lavoro alla fine aumenterà. Avrai bisogno di una GPU in grado di scalare con l’aumento del carico di lavoro. Le GPU cloud possono aiutarti a farlo consentendoti di aggiungere facilmente più GPU senza problemi in modo da poter soddisfare i tuoi maggiori carichi di lavoro. Al contrario, se si desidera ridimensionare, questo è possibile anche rapidamente.

Riduce al minimo i costi

Invece di acquistare GPU fisiche ad alta potenza che costano incredibilmente alte, puoi scegliere le GPU cloud a noleggio che sono disponibili a un costo inferiore su base oraria. Ti verrà addebitato il numero di ore di utilizzo delle GPU cloud, a differenza di quelle fisiche che ti sarebbero costate molto anche se le utilizzi poco.

Cancella le risorse locali

Le GPU cloud non consumano le tue risorse locali, a differenza delle GPU fisiche che occupano una quantità significativa di spazio sul tuo computer. Per non parlare del fatto che se esegui un modello ML su larga scala o esegui il rendering di un’attività, il tuo computer rallenta.

Per questo, puoi considerare di esternalizzare la potenza di calcolo al cloud senza stressare il tuo computer e usarlo con facilità. Basta usare il computer per controllare tutto invece di dargli tutta la pressione per gestire il carico di lavoro e le attività di calcolo.

Risparmia tempo

Le GPU cloud offrono ai progettisti la flessibilità di un’iterazione rapida con tempi di rendering più rapidi. Puoi risparmiare molto tempo completando un’attività in pochi minuti che richiedeva ore o giorni. Pertanto, la produttività del tuo team aumenterà in modo significativo in modo da poter investire tempo nell’innovazione invece che nel rendering o nei calcoli.

In che modo le GPU aiutano nel deep learning e nell’intelligenza artificiale?

Il deep learning è alla base dell’intelligenza artificiale. È una tecnica ML avanzata che enfatizza l’apprendimento rappresentativo con l’aiuto delle reti neurali artificiali (ANN). Il modello di deep learning viene utilizzato per elaborare set di dati di grandi dimensioni o processi altamente computazionali.

Quindi, come entrano in gioco le GPU?

Le GPU sono progettate per eseguire calcoli paralleli o calcoli multipli contemporaneamente. Le GPU possono sfruttare la capacità del modello di deep learning per accelerare attività di calcolo di grandi dimensioni.

Poiché le GPU hanno molti core, offrono eccellenti calcoli di elaborazione parallela. Inoltre, hanno una maggiore larghezza di banda della memoria per ospitare enormi quantità di dati per i sistemi di deep learning. Pertanto, sono ampiamente utilizzati per l’addestramento di modelli AI, il rendering di modelli CAD, la riproduzione di videogiochi ricchi di grafica e altro ancora.

Inoltre, se vuoi sperimentare più algoritmi contemporaneamente, puoi eseguire numerose GPU separatamente. Facilita diversi processi su GPU separate senza parallelismo. Per questo, puoi utilizzare più GPU su diverse macchine fisiche o in una singola macchina per distribuire modelli di dati pesanti.

Come iniziare a utilizzare Cloud GPU

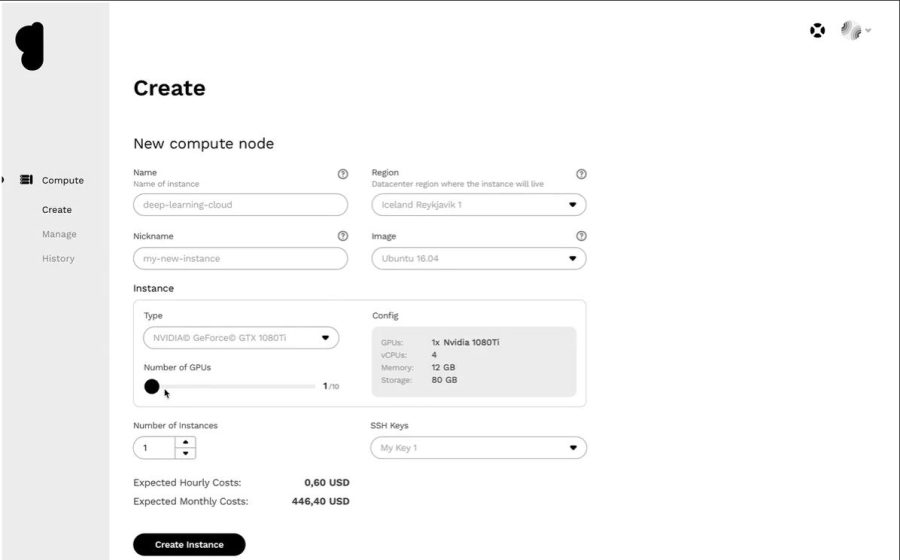

Iniziare con le GPU cloud non è scienza missilistica. In effetti, tutto è facile e veloce se riesci a capire le basi. Prima di tutto, devi scegliere un provider di GPU cloud, ad esempio Google Cloud Platform (GCP).

Quindi, iscriviti a GCP. Qui puoi usufruire di tutti i vantaggi standard che ne derivano, come funzioni cloud, opzioni di archiviazione, gestione del database, integrazione con le applicazioni e altro ancora. Puoi anche utilizzare la loro collaborazione di Google che funziona come Jupyter Notebook per utilizzare una GPU GRATUITAMENTE. Infine, puoi iniziare a eseguire il rendering delle GPU per il tuo caso d’uso.

Quindi, diamo un’occhiata alle varie opzioni disponibili per le GPU cloud per gestire l’IA e enormi carichi di lavoro.

linode

linode offre GPU on-demand per carichi di lavoro di elaborazione parallela come elaborazione video, calcolo scientifico, apprendimento automatico, intelligenza artificiale e altro ancora. Fornisce macchine virtuali ottimizzate per GPU accelerate da NVIDIA Quadro RTX 6000, Tensor, core RT e sfrutta la potenza di CUDA per eseguire carichi di lavoro di ray tracing, deep learning ed elaborazioni complesse.

Trasforma le tue spese in conto capitale in spese operative prendendo l’accesso dalla GPU Linode per sfruttare la potenza della GPU e beneficiare della proposta di valore reale del cloud. Inoltre, Linode ti consente di concentrarti sulle competenze di base invece di preoccuparti dell’hardware.

Le GPU Linode eliminano la barriera per sfruttarle in casi d’uso complessi come lo streaming video, l’intelligenza artificiale e l’apprendimento automatico. Inoltre, riceverai fino a 4 carte per ogni istanza, a seconda della potenza necessaria per i carichi di lavoro previsti.

Quadro RTX 6000 ha 4.608 core CUDA, 576 core Tensor, 72 core RT, 24 GB di memoria GPU GDDR6, 84T RTX-OPS, 10 Giga Rays/sec Rays Cast e prestazioni FP32 di 16,3 TFLOP.

Il prezzo per il piano GPU RTX6000 dedicato plus è di $ 1,5/ora.

NUCLEO di Paperspace

Potenzia il tuo flusso di lavoro organizzativo con l’infrastruttura di elaborazione accelerata di nuova generazione NUCLEO di Paperspace. Offre un’interfaccia semplice e facile da usare per fornire semplici onboarding, strumenti di collaborazione e app desktop per Mac, Linux e Windows. Usalo per eseguire applicazioni ad alta richiesta attraverso una potenza di calcolo illimitata.

CORE fornisce una rete ultraveloce, provisioning istantaneo, supporto per app 3D e API completa per l’accesso programmatico. Ottieni una visione completa della tua infrastruttura con una GUI semplice e intuitiva in un unico posto. Inoltre, ottieni un controllo eccellente con l’interfaccia di gestione di CORE dotata di strumenti robusti e che ti consente di filtrare, ordinare, collegare o creare macchine, reti e utenti.

La potente console di gestione di CORE esegue rapidamente attività come l’aggiunta dell’integrazione di Active Directory o della VPN. Puoi anche gestire facilmente le complesse configurazioni di rete e completare le cose più velocemente in pochi clic.

Inoltre, troverai molte integrazioni facoltative ma utili nel tuo lavoro. Ottieni funzionalità di sicurezza avanzate, unità condivise e altro ancora con questa piattaforma GPU cloud. Goditi le GPU a basso costo ottenendo sconti per l’istruzione, avvisi di fatturazione, fatturazione per un secondo, ecc.

Aggiungi semplicità e velocità al flusso di lavoro a un prezzo iniziale di $ 0,07/ora.

GPU Google Cloud

Ottieni GPU ad alte prestazioni per l’elaborazione scientifica, la visualizzazione 3D e l’apprendimento automatico GPU Google Cloud. Può aiutare a velocizzare l’HPC, selezionare un’ampia gamma di GPU per abbinare i prezzi e le prestazioni e ridurre al minimo il carico di lavoro con personalizzazioni della macchina e prezzi flessibili.

Offrono anche molte GPU come NVIDIA K80, P4, V100, A100, T4 e P100. Inoltre, le GPU Google Cloud bilanciano la memoria, il processore, il disco ad alte prestazioni e fino a 8 GPU in ogni istanza per il singolo carico di lavoro.

Inoltre, hai accesso a reti, analisi dei dati e storage leader del settore. I dispositivi GPU sono disponibili solo in zone specifiche in alcune regioni. Il prezzo dipenderà dalla regione, dalla GPU scelta e dal tipo di macchina. Puoi calcolare il tuo prezzo definendo i tuoi requisiti nel Calcolatore dei prezzi di Google Cloud.

In alternativa, puoi optare per queste soluzioni:

Servizio GPU elastico

Servizio GPU elastico (EGS) fornisce capacità di elaborazione parallele e potenti con la tecnologia GPU. È ideale per molti scenari come l’elaborazione video, la visualizzazione, l’informatica scientifica e il deep learning. EGS utilizza diverse GPU come NVIDIA Tesla M40, NVIDIA Tesla V100, NVIDIA Tesla P4, NVIDIA Tesla P100 e AMD FirePro S7150.

Otterrai vantaggi come servizi di inferenza di deep learning online e formazione, identificazione dei contenuti, riconoscimento di immagini e voce, codifica multimediale HD, videoconferenza, riparazione del film sorgente e 4K/8K HD live.

Inoltre, ottieni opzioni come rendering video, finanza computazionale, previsione climatica, simulazione di collisione, ingegneria genetica, editing non lineare, applicazioni di formazione a distanza e progettazione ingegneristica.

- L’istanza GA1 fornisce fino a 4 GPU AMD FirePro S7150, 160 GB di memoria e 56 vCPU. Contiene 8192 core e 32 GB di memoria GPU che funziona in parallelo e fornisce 15 TFLOPS di precisione singola e un TFLOPS di doppia precisione.

- L’istanza GN4 fornisce fino a 2 GPU NVIDIA Tesla M40, 96 GB di memoria e 56 vCPU. Contiene 6000 core e 24 GB di memoria GPU che offre 14 TFLOPS di precisione singola. Allo stesso modo, troverai molte istanze come GN5, GN5i e GN6.

- EGS supporta internamente 25 Gbit/s e fino a 2.000.000 PPS di larghezza di banda di rete per fornire le massime prestazioni di rete necessarie ai nodi di calcolo. Ha una cache locale ad alta velocità collegata a dischi SSD o ultra cloud.

- Le unità NVMe ad alte prestazioni gestiscono 230.000 IOPS con una latenza I/O di 200 𝝻s e forniscono 1900 Mbit/s di larghezza di banda in lettura e 1100 Mbit/s di larghezza di banda in scrittura.

Puoi scegliere tra diverse opzioni di acquisto in base alle tue esigenze per ottenere le risorse e pagare solo per quelle.

Serie N azzurra

Serie N azzurra di Macchine virtuali (VM) di Azure dispongono di funzionalità GPU. Le GPU sono ideali per la grafica e i carichi di lavoro ad alta intensità di calcolo, aiutando gli utenti a potenziare l’innovazione attraverso vari scenari come il deep learning, l’analisi predittiva e la visualizzazione remota.

Diverse serie N hanno offerte separate per carichi di lavoro specifici.

- La serie NC si concentra sull’apprendimento automatico ad alte prestazioni e sui carichi di lavoro di calcolo. L’ultima versione è NCsv3 che presenta la GPU Tesla V100 di NVIDIA.

- La serie ND si concentra su scenari di inferenza e formazione fondamentalmente per il deep learning. Utilizza GPU NVIDIA Tesla P40. L’ultima versione è NDv2 con GPU NVIDIA Tesla V100.

- La serie NV si concentra sulla visualizzazione remota e su altri carichi di lavoro intensivi di applicazioni supportati dalla GPU NVIDIA Tesla M60.

- Le macchine virtuali NC, NCsv3, ND e NCsv2 offrono l’interconnessione InfiniBand che consente prestazioni di scalabilità verticale. Qui otterrai vantaggi come deep learning, rendering grafico, editing video, giochi, ecc.

IBM Cloud

IBM Cloud ti offre flessibilità, potenza e molte opzioni GPU. Poiché la GPU è la potenza in più che manca a una CPU, IBM Cloud ti aiuta a ottenere l’accesso diretto alla selezione più accessibile del server per una perfetta integrazione con l’architettura, le applicazioni e le API IBM Cloud insieme a una rete distribuita di data center a livello globale.

- Otterrai opzioni GPU per server bare metal come Intel Xeon 4210, scheda grafica NVIDIA T4, 20 core, 32 GB di RAM, 2,20 GHz e 20 TB di larghezza di banda. Allo stesso modo, ottieni anche le opzioni di Intel Xeon 5218 e Intel Xeon 6248.

- Per i server virtuali, ottieni AC1.8 × 60 che ha otto vCPU, 60 GB di RAM, 1 x GPU P100. Qui avrai anche le opzioni di AC2.8×60 e AC2.8×60.

Ottieni la GPU del server bare metal a un prezzo iniziale di $ 819/mese e la GPU del server virtuale a un prezzo iniziale di $ 1,95/ora.

AWS e NVIDIA

AWS e NVIDIA hanno collaborato per fornire continuamente soluzioni basate su GPU convenienti, flessibili e potenti. Include istanze e servizi Amazon EC2 basati su GPU NVIDIA come AWS IoT Greengrass che viene distribuito con i moduli NVIDIA Jetson Nano.

Gli utenti utilizzano AWS e NVIDIA per workstation virtuali, machine learning (ML), servizi IoT e calcolo ad alte prestazioni. Le istanze Amazon EC2 alimentate dalle GPU NVIDIA sono responsabili della fornitura di prestazioni scalabili. Inoltre, utilizza AWS IoT Greengrass per estendere i servizi cloud AWS ai dispositivi perimetrali basati su NVIDIA.

Le GPU NVIDIA A100 Tensor Core alimentano le istanze Amazon EC2 P4d per offrire reti a bassa latenza e throughput elevato leader del settore. Allo stesso modo, troverai molte altre istanze per scenari specifici come Amazon EC2 P3, Amazon EC2 G4, ecc.

Richiedi la prova GRATUITA e sperimenta la potenza della GPU fino all’edge dal cloud.

OVH cloud

OVH cloud fornisce server cloud progettati per elaborare enormi carichi di lavoro paralleli. Le GPU hanno molte istanze integrate con i processori grafici NVIDIA Tesla V100 per soddisfare le esigenze di deep learning e machine learning.

Aiutano ad accelerare l’elaborazione nel campo dell’informatica grafica e dell’intelligenza artificiale. OVH collabora con NVIDIA per offrire la migliore piattaforma con accelerazione GPU per elaborazione ad alte prestazioni, intelligenza artificiale e deep learning.

Usa il modo più semplice per distribuire e mantenere i container con accelerazione GPU attraverso un catalogo completo. Fornisce una delle quattro schede alle istanze direttamente tramite PCI Passthrough senza alcun livello di virtualizzazione per dedicare tutti i poteri al tuo utilizzo.

I servizi e le infrastrutture di OVHcloud sono certificati ISO/IEC 27017, 27001, 27701 e 27018. Le certificazioni indicano che OVHcloud dispone di un sistema di gestione della sicurezza delle informazioni (ISMS) per gestire le vulnerabilità, implementare la continuità aziendale, gestire i rischi e implementare un sistema di gestione delle informazioni sulla privacy (PIMS).

Inoltre, NVIDIA Tesla V100 ha molte caratteristiche preziose come PCIe 32 GB/s, 16 GB HBM2 di capacità, 900 GB/s di larghezza di banda, doppia precisione-7 teraFLOP, singola precisione-14 teraFLOP e deep learning-112 teraFLOP.

GPU Lambda

Addestra modelli di deep learning, ML e AI con Lambda GPU Cloud e scalare da una macchina al numero totale di VM in pochi clic. Ottieni i framework principali preinstallati e l’ultima versione dello Stack lambda che include driver CUDA e framework di deep learning.

Accedi rapidamente all’ambiente di sviluppo Jupyter Notebook dedicato per ogni macchina dalla dashboard. Usa SSH direttamente con una delle chiavi SSH o connettiti tramite il Web Terminal nella dashboard cloud per l’accesso diretto.

Ogni istanza supporta un massimo di 10 Gbps di larghezza di banda tra i nodi che consente l’addestramento sparso con framework come Horovod. Puoi anche risparmiare tempo nell’ottimizzazione del modello scalando il numero di GPU su una o più istanze.

Con Lambda GPU Cloud, puoi persino risparmiare il 50% sull’elaborazione, ridurre il TCO del cloud e non ottenere mai impegni pluriennali. Usa una singola GPU RTX 6000 con sei VCPU, 46 GiB di RAM, 658 GiB di storage temporaneo a soli $ 1,25/ora. Scegli tra molte istanze in base alle tue esigenze per ottenere un prezzo on-demand per il tuo utilizzo.

Genesi nuvola

Ottieni una piattaforma GPU cloud efficiente a una tariffa molto conveniente da Genesi nuvola. Hanno accesso a molti data center efficienti in tutto il mondo con i quali stanno collaborando per offrire una vasta gamma di applicazioni.

Tutti i servizi sono sicuri, scalabili, robusti e automatizzati. Genesis Cloud fornisce potenza di elaborazione GPU illimitata per effetti visivi, apprendimento automatico, transcodifica o archiviazione, analisi di Big Data e molti altri.

Genesis Cloud offre molte funzionalità avanzate GRATUITAMENTE come snapshot per salvare il tuo lavoro, gruppi di sicurezza per il traffico di rete, volumi di archiviazione per i big data set, FastAI, PyTorch, immagini preconfigurate e un’API pubblica per TensorFlow.

Ha GPU NVIDIA e AMD di diversi tipi. Inoltre, addestra la rete neurale o genera film animati sfruttando la potenza del GPU computing. I loro data center funzionano con il 100% di energia rinnovabile da fonti geotermiche per ridurre le emissioni di carbonio.

Il loro prezzo è inferiore dell’85% rispetto ad altri fornitori poiché pagherai per incrementi di livello minuto. Puoi anche risparmiare di più con sconti a lungo termine e prerilasciabili.

Conclusione 👩🏫

Le GPU cloud sono progettate per offrire prestazioni, velocità, scalabilità, spazio e praticità incredibili. Quindi, prendi in considerazione la possibilità di scegliere la tua piattaforma GPU cloud preferita con funzionalità pronte all’uso per accelerare i tuoi modelli di deep learning e gestire facilmente i carichi di lavoro dell’IA.