Esistono terabyte e petabyte di dati in questa era di Internet, con una crescita esponenziale sullo stesso. Ma come consumiamo questi dati e li traduciamo in informazioni utili per migliorare la disponibilità del servizio?

Dati validi, nuovi e comprensibili sono tutto ciò di cui le aziende hanno bisogno per i loro modelli di knowledge discovery.

Per questo motivo, le aziende stanno applicando l’analisi in molti modi diversi per scoprire dati di qualità.

Ma da dove inizia tutto? La risposta è una disputa sui dati.

Iniziamo!

Sommario:

Che cos’è il Data Wrangling?

Il data wrangling è l’atto di pulire, strutturare e trasformare i dati grezzi in formati che semplificano i processi di analisi dei dati. La disputa sui dati spesso implica l’utilizzo di set di dati complessi e disordinati che non sono pronti per i processi della pipeline di dati. Il data wrangling sposta i dati grezzi in uno stato raffinato o i dati raffinati in uno stato ottimizzato e un livello pronto per la produzione.

Alcune delle attività note nella disputa dei dati includono:

- Unione di più set di dati in un unico set di dati di grandi dimensioni per l’analisi.

- Esame dei dati mancanti/lacune.

- Rimozione di valori anomali o anomalie nei set di dati.

- Standardizzazione degli input.

I grandi archivi di dati coinvolti nei processi di data wrangling sono generalmente al di là dell’ottimizzazione manuale, e richiedono metodi automatizzati di preparazione dei dati per produrre dati più accurati e di qualità.

Obiettivi del Data Wrangling

Oltre a preparare i dati per l’analisi come obiettivo più grande, altri obiettivi includono:

- Creazione di dati validi e nuovi da dati disordinati per guidare il processo decisionale nelle aziende.

- Standardizzazione dei dati grezzi in formati che i sistemi Big Data possono acquisire.

- Ridurre il tempo impiegato dagli analisti di dati durante la creazione di modelli di dati presentando dati ordinati.

- Creare coerenza, completezza, usabilità e sicurezza per qualsiasi set di dati consumato o archiviato in un data warehouse.

Approcci comuni al Data Wrangling

Alla scoperta

Prima che i data engineer inizino le attività di preparazione dei dati, devono capire come vengono archiviati, le dimensioni, quali record vengono conservati, i formati di codifica e altri attributi che descrivono qualsiasi set di dati.

Strutturare

Questo processo prevede l’organizzazione dei dati per assumere formati facilmente utilizzabili. Potrebbe essere necessario strutturare i set di dati non elaborati in base all’aspetto delle colonne, al numero di righe e all’ottimizzazione di altri attributi di dati per semplificare l’analisi.

Pulizia

I set di dati strutturati devono essere eliminati dagli errori intrinseci e da tutto ciò che può distorcere i dati all’interno. La pulizia comporta quindi la rimozione di più voci di celle con dati simili, l’eliminazione di celle vuote e dati anomali, la standardizzazione degli input, la ridenominazione di attributi confusi e altro ancora.

Arricchimento

Una volta che i dati hanno superato le fasi di strutturazione e pulizia, è necessario valutare l’utilità dei dati e aumentarla con i valori di altri set di dati mancanti per fornire la qualità dei dati desiderata.

Convalida

Il processo di convalida comporta aspetti di programmazione iterativa che fanno luce sulla qualità, la coerenza, l’usabilità e la sicurezza dei dati. La fase di convalida garantisce il raggiungimento di tutte le attività di trasformazione e contrassegna i set di dati come pronti per le fasi di analisi e modellazione.

Presentare

Dopo che tutte le fasi sono state superate, i set di dati confusi vengono presentati/condivisi all’interno di un’organizzazione per l’analisi. In questa fase viene condivisa anche la documentazione delle fasi di preparazione e dei metadati generati durante il processo di disputa.

Talendo

Talendo è una piattaforma di gestione dei dati unificata racchiusa in 3 data fabric per fornire dati affidabili e sani. Talend presenta Integrazione dei dati, Applicazione e integrazione e Integrità e governance dei dati. La disputa dei dati in Talend avviene tramite uno strumento point and click basato su browser che consente la preparazione di dati batch, in blocco e in tempo reale: profilazione, pulizia e documentazione dei dati.

Talend data fabric gestisce ogni fase del ciclo di vita dei dati, bilanciando attentamente la disponibilità dei dati, l’usabilità, la sicurezza e l’integrità di tutti i dati aziendali.

Sei mai stato preoccupato per le tue diverse fonti di dati? L’approccio unificato di Talend fornisce una rapida integrazione dei dati da tutte le origini dati (database, archivi cloud ed endpoint API), consentendo la trasformazione e la mappatura di tutti i dati con controlli di qualità senza interruzioni.

L’integrazione dei dati in Talend è consentita tramite strumenti self-service come connettori che consentono agli sviluppatori di acquisire dati da qualsiasi fonte automaticamente e classificare adeguatamente i dati.

Caratteristiche di Talend

Integrazione universale dei dati

Talend consente alle aziende di gestire qualsiasi tipo di dati da diverse origini dati: ambienti cloud o on-premise.

Flessibile

Talend va oltre il fornitore o la piattaforma quando costruisce pipeline di dati dai tuoi dati integrati. Dopo aver creato pipeline di dati dai dati inseriti, Talend ti consente di eseguire le pipeline ovunque.

Qualità dei dati

Con funzionalità di apprendimento automatico come la deduplicazione, la convalida e la standardizzazione dei dati, Talend pulisce automaticamente i dati inseriti.

Supporto per integrazioni di applicazioni e API

Dopo che il significato è stato ricavato dai tuoi dati attraverso gli strumenti self-service di Talend, puoi condividere i tuoi dati tramite API intuitive. Gli endpoint dell’API Talend possono esporre le tue risorse di dati a piattaforme SaaS, JSON, AVRO e B2B attraverso strumenti avanzati di mappatura e trasformazione dei dati.

R

R è un linguaggio di programmazione ben sviluppato ed efficace per affrontare l’analisi esplorativa dei dati per applicazioni scientifiche e aziendali.

Creato come software gratuito per il calcolo statistico e la grafica, R è sia un linguaggio che un ambiente per il confronto, la modellazione e la visualizzazione dei dati. L’ambiente R fornisce una suite di pacchetti software mentre il linguaggio R integra una serie di tecniche statistiche, di clustering, classificazione, analisi e grafiche che aiutano a manipolare i dati.

Caratteristiche di r

Ricco set di pacchetti

I data engineer hanno più di 10.000 pacchetti ed estensioni standardizzati tra cui scegliere dalla Comprehensive R Archive Network (CRAN). Ciò semplifica la disputa e l’analisi dei dati.

Estremamente potente

Con i pacchetti di calcolo distribuito disponibili, R può eseguire manipolazioni complesse e dirette (matematiche e statistiche) su oggetti di dati e set di dati in pochi secondi.

Supporto multipiattaforma

R è indipendente dalla piattaforma, in grado di funzionare su molti sistemi operativi. È anche compatibile con altri linguaggi di programmazione che aiutano a manipolare compiti computazionalmente pesanti.

Imparare R è facile.

Trifatto

Trifatto è un ambiente cloud interattivo per la profilazione dei dati eseguiti su modelli di machine learning e analisi. Questo strumento di ingegneria dei dati mira a creare dati comprensibili indipendentemente da quanto siano disordinati o complessi i set di dati. Gli utenti possono rimuovere le voci doppie e riempire le celle vuote nei set di dati tramite la deduplicazione e le trasformazioni di trasformazione lineare.

Questo strumento di data wrangling tiene d’occhio i valori anomali e i dati non validi in qualsiasi set di dati. Con un semplice clic e trascinamento, i dati a portata di mano vengono classificati e trasformati in modo intelligente utilizzando suggerimenti basati sull’apprendimento automatico per accelerare la preparazione dei dati.

La disputa di dati in Trifacta avviene attraverso profili visivi accattivanti che possono ospitare personale non tecnico e tecnico. Con le trasformazioni visualizzate e intelligenti, Trifacta è orgogliosa del suo design per gli utenti in mente.

Che si tratti di importare dati da data mart, data warehouse o data lake, gli utenti sono protetti dalle complessità della preparazione dei dati.

Caratteristiche di Trifacta

Integrazioni cloud senza interruzioni

Supporta i carichi di lavoro di preparazione in qualsiasi ambiente cloud o ibrido per consentire agli sviluppatori di ingerire set di dati per litigare, indipendentemente da dove vivono.

Dati multipli Metodi di standardizzazione

Trifacta wrangler ha diversi meccanismi per identificare i modelli nei dati e standardizzare gli output. Gli ingegneri dei dati possono scegliere la standardizzazione in base al modello, alla funzione o al mix and match.

Flusso di lavoro semplice

Trifacta organizza i lavori di preparazione dei dati sotto forma di flussi. Un flusso contiene uno o più dataset più le relative ricette (passaggi definiti che trasformano i dati).

Un flusso, quindi, riduce il tempo che gli sviluppatori dedicano all’importazione, alla disputa, alla profilazione e all’esportazione dei dati.

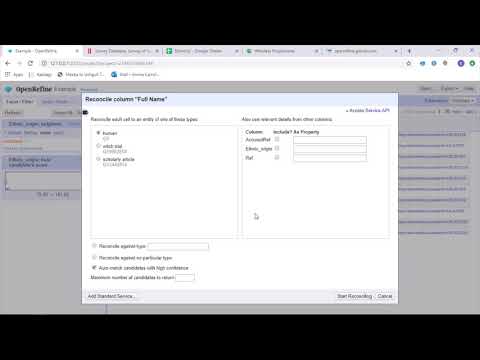

ApriPerfeziona

ApriPerfeziona è uno strumento maturo e open source per lavorare con dati disordinati. Come strumento di pulizia dei dati, OpenRefine esplora i set di dati in pochi secondi applicando complesse trasformazioni di celle per presentare i formati di dati desiderati.

OpenRefine si avvicina al data wrangling attraverso filtri e partizioni sui set di dati usando espressioni regolari. Utilizzando il General Refine Expression Language integrato, i data engineer possono apprendere e visualizzare i dati utilizzando facet, filtri e tecniche di ordinamento prima di eseguire operazioni avanzate sui dati per le estrazioni di entità.

OpenRefine consente agli utenti di lavorare sui dati come progetti in cui set di dati da più file di computer, URL Web e database possono essere inseriti in tali progetti con la possibilità di essere eseguiti localmente sui computer degli utenti.

Attraverso le espressioni, gli sviluppatori possono estendere la pulizia e la trasformazione dei dati ad attività come la divisione/unione di celle multivalore, la personalizzazione di facet e il recupero dei dati in colonne utilizzando URL esterni.

Caratteristiche di OpenRefine

Strumento multipiattaforma

OpenRefine è progettato per funzionare con i sistemi operativi Windows, Mac e Linux tramite configurazioni di installazione scaricabili.

Ricco set di API

Presenta API OpenRefine, API di estensione dati, API di riconciliazione e altre API che supportano l’interazione degli utenti con i dati.

Datameer

Datameer è uno strumento di trasformazione dei dati SaaS creato per semplificare la raccolta e l’integrazione dei dati attraverso i processi di ingegneria del software. Datameer consente l’estrazione, la trasformazione e il caricamento di set di dati in data warehouse su cloud come Snowflake.

Questo strumento di data wrangling funziona bene con formati di set di dati standard come CSV e JSON, consentendo agli ingegneri di importare dati in vari formati per l’aggregazione.

Datameer offre documentazione dei dati simile a un catalogo, profilazione approfondita dei dati e discovery per soddisfare tutte le esigenze di trasformazione dei dati. Lo strumento mantiene un profilo di dati visivo approfondito che consente agli utenti di tracciare campi e valori non validi, mancanti o periferici e la forma generale dei dati.

In esecuzione su un data warehouse scalabile, Datameer trasforma i dati per analisi significative attraverso stack di dati efficienti e funzioni simili a Excel.

Datameer presenta un’interfaccia utente ibrida, di codice e senza codice per ospitare ampi team di analisi dei dati che possono creare facilmente pipeline ETL complesse.

Caratteristiche di Datameer

Ambienti utente multipli

Dispone di ambienti di trasformazione dei dati multi-persona: codice basso, codice e ibrido, per supportare persone esperte di tecnologia e non.

Spazi di lavoro condivisi

Datameer consente ai team di riutilizzare e collaborare sui modelli per velocizzare i progetti.

Documentazione ricca di dati

Datameer supporta sia la documentazione dei dati di sistema che quella generata dall’utente tramite metadati e descrizioni, tag e commenti in stile wiki.

Parole finali 👩🏫

L’analisi dei dati è un processo complesso, che richiede che i dati siano organizzati in modo appropriato per trarre inferenze significative e fare previsioni. Gli strumenti di Data Wrangling ti aiutano a formattare grandi quantità di dati grezzi per aiutarti a eseguire analisi avanzate. Scegli lo strumento più adatto alle tue esigenze e diventa un professionista di Analytics!

Ti potrebbe piacere:

I migliori strumenti CSV per convertire, formattare e convalidare.