Per le persone che non hanno familiarità con la programmazione, la creazione di un web scraper potrebbe essere difficile. Fortunatamente, il software di scraping web è accessibile sia ai programmatori che ai non programmatori. Il software Web scraping è un software particolarmente progettato per ottenere dati rilevanti dai siti Web. Questi strumenti sono utili a chiunque desideri acquisire dati da Internet in qualche modo. Queste informazioni vengono registrate in un file locale sul computer o in un database. È la tecnica di raccolta autonoma di dati per il web. Portiamo a un elenco dei 31 migliori strumenti gratuiti per il web scraping.

Sommario:

31 migliori strumenti di web scraping

Un elenco selezionato dei migliori strumenti di web scraping è disponibile qui. Questo elenco contiene strumenti commerciali e open source, nonché collegamenti ai rispettivi siti Web.

1. Supera l’astuzia

Outwit è un componente aggiuntivo di Firefox semplice da installare dal negozio di componenti aggiuntivi di Firefox.

- Questo strumento di raccolta dati semplifica la raccolta dei contatti dal Web e tramite e-mail.

- A seconda delle tue esigenze, avrai tre alternative per l’acquisto di questo prodotto.

- Pro

-

Esperto, e

-

Sono disponibili edizioni Enterprise.

- L’esattezza dei dati dai siti che utilizzano l’hub Outwit non richiede alcuna conoscenza di programmazione.

- Puoi iniziare a raschiare centinaia di pagine Web con un solo clic sul pulsante di esplorazione.

2. PareseHub

ParseHub è un altro dei migliori strumenti di scraping web gratuiti.

- Prima di scaricare i dati, ripulisci il testo e l’HTML.

- È semplice come selezionare i dati che desideri estrarre utilizzando il nostro sofisticato web scraper.

- È uno dei migliori strumenti di scraping dei dati poiché consente di archiviare i dati raschiati in qualsiasi formato per ulteriori analisi.

- L’interfaccia grafica intuitiva

- Questo strumento di scraping di Internet ti consente di raccogliere e salvare automaticamente i dati sui server.

3. Apificare

Apify è un altro dei migliori strumenti di web scraping e automazione che ti consente di costruire un’API per qualsiasi sito Web, con proxy residenziali e data center integrati che semplificano l’estrazione dei dati.

- Apify si occupa dell’infrastruttura e della fatturazione, consentendo agli sviluppatori di fare soldi passivi progettando strumenti per gli altri.

- Alcuni dei connettori disponibili sono Zapier, Integromat, Keboola e Airbyte.

- Apify Store offre soluzioni di scraping già pronte per siti Web popolari come Instagram, Facebook, Twitter e Google Maps.

- JSON, XML, CSV, HTML ed Excel sono tutti moduli strutturati che possono essere scaricati.

- HTTPS, targeting per geolocalizzazione, rotazione IP intelligente e proxy SERP di Google sono tutte funzionalità di Apify Proxy.

- Prova proxy gratuita di 30 giorni con un credito per la piattaforma di 5 USD.

4. Scaffalatura

Scrapestack è utilizzato da oltre 2.000 aziende e si affidano a questa API unica, basata su apilayer. È uno dei migliori strumenti di scraping web gratuiti.

- Utilizza un pool di indirizzi IP mondiale di 35 milioni di data center.

- Consente di eseguire più richieste API contemporaneamente.

- Sono supportati sia la decrittazione CAPTCHA che il rendering JavaScript.

- Sono disponibili sia opzioni gratuite che a pagamento.

- Scrapestack è un’API REST di scraping online che opera in tempo reale.

- L’API scrapestack ti consente di raschiare le pagine Web in millisecondi utilizzando milioni di IP proxy, browser e CAPTCHA.

- Le richieste di web scraping possono essere inviate da più di 100 diverse località in tutto il mondo.

5. Minatore

Per Windows e Mac OS, FMiner è un popolare programma di scraping online, estrazione dati, scansione dello schermo, macro e supporto Web.

- I dati possono essere raccolti da siti Web dinamici Web 2.0 difficili da scansionare.

- Consente di creare un progetto di estrazione dati utilizzando l’editor visivo, che è semplice da usare.

- Utilizza una combinazione di strutture di collegamento, menu a discesa e corrispondenza di pattern URL per consentirti di esplorare le pagine Web.

- È possibile utilizzare servizi di decaptcha automatici di terze parti o l’input manuale per indirizzare la protezione CAPTCHA del sito Web.

6. Sequenza

Il Sequentum è un robusto strumento per i big data per ottenere dati online affidabili. È un altro dei migliori strumenti di scraping web gratuiti.

- Rispetto alle soluzioni alternative, l’estrazione dei dati online sta diventando più rapida.

- È possibile effettuare la transizione tra più piattaforme utilizzando questa funzione.

- È uno dei web scraper più potenti per far crescere la tua azienda. Contiene funzionalità semplici tra cui un editor visivo point-and-click.

- L’API Web dedicata ti assisterà nello sviluppo di app Web consentendoti di eseguire dati Web direttamente dal tuo sito Web.

7. Agente

Agenty è un programma di scraping di dati, estrazione di testo e OCR che utilizza Robotic Process Automation.

- Questo programma ti consente di riutilizzare tutti i tuoi dati elaborati per scopi di analisi.

- Puoi creare un agente con pochi clic del mouse.

- Riceverai un messaggio di posta elettronica al termine del tuo compito.

- Ti consente di connetterti a Dropbox e utilizzare FTP sicuro.

- Tutti i registri delle attività per tutte le occorrenze sono disponibili per la visualizzazione.

- Ti aiuta a migliorare il successo della tua azienda.

- Consente di implementare facilmente regole aziendali e logica personalizzata.

8. Import.io

Importando i dati da una determinata pagina Web ed esportando i dati in CSV, l’applicazione di scraping web import.io ti aiuta a formare i tuoi set di dati. È anche uno dei migliori strumenti di web scraping. Di seguito sono riportate le caratteristiche di questo strumento.

- I moduli Web/gli accessi sono semplici da usare.

- È una delle migliori soluzioni di scraping dei dati per sfruttare API e webhook per integrare i dati nelle app.

- Puoi ottenere informazioni dettagliate tramite report, grafici e visualizzazioni.

- L’estrazione dei dati dovrebbe essere pianificata in anticipo.

- Import.io cloud ti consente di archiviare e accedere ai dati.

- L’interazione con il Web e i flussi di lavoro può essere automatizzata.

9. Webz.io

Webz.io ti consente di eseguire la scansione di centinaia di siti Web e di accedere subito a dati strutturati e in tempo reale. È anche uno dei migliori strumenti di scraping web gratuiti.

È possibile acquisire set di dati organizzati e leggibili dalla macchina nei formati JSON e XML.

- Ti dà accesso a feed storici che coprono oltre dieci anni di dati.

- Consente di accedere a un ampio database di feed di dati senza dover sostenere spese aggiuntive.

- Puoi utilizzare un filtro avanzato per eseguire analisi dettagliate e alimentare set di dati.

10. Raschietto

Scrape Owl è una piattaforma web scraping facile da usare ed economica.

- L’obiettivo principale di Scrape Owl è quello di raschiare qualsiasi tipo di dati, inclusi e-commerce, bacheche di lavoro e annunci immobiliari.

- Prima di estrarre il materiale, puoi eseguire JavaScript personalizzato.

- È possibile utilizzare le posizioni per aggirare le restrizioni locali e accedere ai contenuti locali.

- Fornisce una funzione di attesa affidabile.

- È supportato il rendering JavaScript a pagina intera.

- Questa applicazione può essere utilizzata direttamente su un foglio Google.

- Offre una prova gratuita di 1000 crediti per provare il servizio prima di acquistare qualsiasi abbonamento. Non è necessario utilizzare una carta di credito.

11. Ape raschiante

Scrapingbee è un’API di web scraping che si occupa delle impostazioni proxy e dei browser headless.

- Può eseguire Javascript sulle pagine e ruotare i proxy per ogni richiesta, così puoi leggere l’HTML grezzo senza essere inserito nella lista nera.

- È inoltre disponibile una seconda API per l’estrazione dei risultati di ricerca di Google.

- Il rendering JavaScript è supportato.

- Ha una funzione di rotazione proxy automatizzata.

- Questa applicazione può essere utilizzata direttamente su Fogli Google.

- Per utilizzare il programma è necessario il browser web Chrome.

- È l’ideale per lo scraping di Amazon.

- Ti consente di raschiare i risultati di Google.

12. Dati luminosi

Bright Data è la piattaforma di dati online leader a livello mondiale, che offre una soluzione conveniente per raccogliere dati Web pubblici su larga scala, convertire facilmente dati non strutturati in dati strutturati e fornire un’esperienza cliente superiore pur essendo completamente trasparente e conforme.

- È il più adattabile poiché viene fornito con soluzioni prefabbricate ed è espandibile e regolabile.

- Il Data Collector di nuova generazione di Bright Data fornisce un flusso di dati automatizzato e personalizzato su un’unica dashboard, indipendentemente dalle dimensioni della raccolta.

- È aperto 24 ore su 24, sette giorni su sette e offre assistenza ai clienti.

- Dalle tendenze dell’e-commerce e dai dati dei social network alle informazioni sulla concorrenza e alle ricerche di mercato, i set di dati sono personalizzati in base alle esigenze della tua azienda.

- Puoi concentrarti sulla tua attività principale automatizzando l’accesso a dati affidabili nel tuo settore.

- È il più efficiente poiché utilizza soluzioni senza codice e utilizza meno risorse.

- Più affidabile, con dati della migliore qualità, tempi di attività più elevati, dati più rapidi e un migliore servizio clienti.

13. API raschietto

Puoi utilizzare lo strumento API Scraper per gestire proxy, browser e CAPTCHA.

- Lo strumento offre velocità e affidabilità senza rivali, consentendo la creazione di web scraper scalabili.

- Puoi ottenere l’HTML da qualsiasi pagina Web con una singola chiamata API.

- È semplice da configurare poiché tutto ciò che devi fare è inviare una richiesta GET con la tua chiave API e URL all’endpoint API.

- Consente di eseguire il rendering di JavaScript più facilmente.

- Ti consente di personalizzare il tipo di richiesta e le intestazioni per ogni richiesta.

- Proxy rotanti con una posizione geografica

14. Dexi intelligente

Dexi intelligent è un’applicazione di scraping online che ti consente di trasformare qualsiasi quantità di dati web in un rapido valore commerciale.

- Questo strumento di scraping online ti consente di risparmiare tempo e denaro per la tua azienda.

- Ha migliorato la produttività, la precisione e la qualità.

- Consente l’estrazione dei dati più veloce ed efficiente.

- Ha un sistema di acquisizione delle conoscenze su larga scala.

15. Diffbot

Diffbot ti consente di ottenere rapidamente una varietà di fatti importanti da Internet.

- Con gli estrattori di intelligenza artificiale, sarai in grado di estrarre dati strutturati accurati da qualsiasi URL.

- Non ti verrà addebitato alcun costo per lo scraping del sito Web che richiede tempo o per la richiesta manuale.

- Per creare un’immagine completa e accurata di ogni oggetto, molte origini dati vengono unite.

- Puoi estrarre dati strutturati da qualsiasi URL con AI Extractors.

- Con Crawlbot, puoi aumentare la tua estrazione a decine di migliaia di domini.

- La funzionalità Knowledge Graph fornisce al Web dati accurati, completi e approfonditi di cui la BI ha bisogno per fornire insight significativi.

16. Streamer di dati

Data Streamer è una tecnologia che ti consente di ottenere materiale di social networking da tutto Internet.

- È uno dei più grandi scraper online che utilizza l’elaborazione del linguaggio naturale per recuperare metadati cruciali.

-

Kibana ed Elasticsearch vengono utilizzati per fornire una ricerca full-text integrata.

- Basato su algoritmi di recupero delle informazioni, rimozione boilerplate integrata ed estrazione di contenuti.

- Costruito su un’infrastruttura a tolleranza d’errore per fornire un’elevata disponibilità delle informazioni.

17. Mozenda

Puoi estrarre testo, foto e materiale PDF da pagine web utilizzando Mozenda.

- Puoi utilizzare lo strumento o il database Bl che preferisci per raccogliere e pubblicare dati online.

- È uno dei migliori strumenti di scraping online per organizzare e formattare i file di dati per la pubblicazione.

- Con un’interfaccia punta e clicca, puoi creare agenti web scraping in pochi minuti.

- Per raccogliere dati Web in tempo reale, utilizzare le funzionalità Job Sequencer e Request Blocking.

- La gestione dell’account e il servizio clienti sono tra i migliori del settore.

18. Estensione per Chrome di Data Miner

Il web scraping e l’acquisizione dei dati sono semplificati con il plug-in del browser Data Miner.

- Ha la capacità di eseguire la scansione di diverse pagine e l’estrazione di dati dinamici.

- La selezione dei dati può essere effettuata in vari modi.

- Esamina le informazioni che sono state raschiate.

- I dati raschiati possono essere salvati come file CSV.

- L’archiviazione locale viene utilizzata per archiviare i dati raschiati.

- Il componente aggiuntivo di Chrome Web Scraper estrae i dati da siti dinamici.

- it Le Sitemap possono essere importate ed esportate.

19. Scarso

Scrapy è anche uno dei migliori strumenti di web scraping. È un framework di scraping online open source basato su Python per la creazione di web scraper.

- Ti fornisce tutti gli strumenti necessari per estrarre rapidamente i dati dai siti Web, analizzarli e salvarli nella struttura e nel formato che preferisci.

- Questo strumento di scraping dei dati è indispensabile se si dispone di un progetto di scraping di dati di grandi dimensioni e si desidera renderlo il più efficiente possibile preservando molta flessibilità.

- I dati possono essere esportati come JSON, CSV o XML.

- Linux, Mac OS X e Windows sono tutti supportati.

- È sviluppato sulla base della tecnologia di rete asincrona Twisted, che è una delle sue caratteristiche principali.

- Scrapy è noto per la sua semplicità d’uso, la vasta documentazione e la comunità attiva.

20. ScrapeHero Cloud

ScrapeHero ha impiegato anni di conoscenza della scansione del Web e l’ha trasformata in crawler e API pre-costruiti economici e facili da usare per lo scraping di dati da siti come Amazon, Google, Walmart e altri.

- I crawler di ScrapeHero Cloud includono proxy a rotazione automatica e l’opzione per eseguire più crawler contemporaneamente.

- Non è necessario scaricare o imparare a utilizzare strumenti o software di scraping dei dati per utilizzare ScrapeHero Cloud.

- I crawler ScrapeHero Cloud ti consentono di acquisire istantaneamente i dati ed esportarli nei formati JSON, CSV o Excel.

- I client del piano Gratuito e Lite di ScrapeHero Cloud ricevono assistenza tramite e-mail, mentre tutti gli altri piani ricevono il servizio prioritario.

- I crawler ScrapeHero Cloud possono anche essere configurati per soddisfare i requisiti specifici dei clienti.

- È un web scraper basato su browser che funziona con qualsiasi browser web.

- Non hai bisogno di alcuna conoscenza di programmazione o di sviluppare uno scraper; è facile come fare clic, copiare e incollare!

21. Raschietto dati

Data Scraper è un’applicazione di scraping online gratuita che estrae i dati da una singola pagina Web e li salva come file CSV o XSL.

- È un’estensione del browser che converte i dati in un formato tabulare ordinato.

- L’installazione del plug-in richiede l’utilizzo del browser Google Chrome.

- Puoi raschiare 500 pagine ogni mese con la versione gratuita; ma, se desideri raschiare più pagine, devi eseguire l’aggiornamento a uno dei piani costosi.

22. Visual Web Ripper

Visual Web Ripper è uno strumento di scraping automatico dei dati per i siti Web.

- Le strutture di dati vengono raccolte da siti Web o risultati di ricerca utilizzando questo strumento.

- Puoi esportare i dati in file CSV, XML ed Excel e presenta un’interfaccia intuitiva.

- Può anche raccogliere dati da siti Web dinamici, come quelli che utilizzano AJAX.

- Devi semplicemente impostare alcuni modelli e il web scraper gestirà il resto.

- Visual Web Ripper offre opzioni di pianificazione e ti invia persino un’e-mail se un progetto fallisce.

23. Octoparse

Octparse è un’applicazione di scraping di pagine Web di facile utilizzo con un’interfaccia visiva. È uno dei migliori strumenti di scraping web gratuiti. Di seguito sono riportate le caratteristiche di questo strumento.

- La sua interfaccia point-and-click semplifica la selezione delle informazioni che desideri estrarre da un sito Web. Octparse può gestire pagine Web sia statiche che dinamiche grazie ad AJAX, JavaScript, cookie e altre funzionalità.

- Sono ora accessibili servizi cloud avanzati che consentono di estrarre grandi quantità di dati.

- Le informazioni raschiate possono essere salvate come file TXT, CSV, HTML o XLSX.

- La versione gratuita di Octparse ti consente di costruire fino a 10 crawler; tuttavia, i piani di abbonamento a pagamento includono funzionalità come un’API e un gran numero di proxy IP anonimi, che accelereranno l’estrazione e ti consentiranno di scaricare grandi volumi di dati in tempo reale.

24. Web Harvey

Il web scraper visivo di WebHarvey ha un browser integrato per lo scraping dei dati dai siti online. È anche uno dei migliori strumenti di web scraping. Ecco alcune caratteristiche di questo strumento.

- Offre un’interfaccia point-and-click che semplifica la selezione degli articoli.

- Questo raschietto ha il vantaggio di non richiedere la scrittura di alcun codice.

-

I file CSV, JSON e XML possono essere utilizzati per salvare i dati.

- È anche possibile salvarlo in un database SQL. WebHarvey dispone di una funzione di scraping di categorie a più livelli che può estrarre i dati dalle pagine degli elenchi seguendo ciascun livello di connessioni di categoria.

- Le espressioni regolari possono essere utilizzate con lo strumento di scraping di Internet, offrendoti ulteriore libertà.

- Puoi configurare server proxy per mantenere nascosto il tuo IP mentre estrai dati dai siti Web, consentendoti di preservare una certa misura di privacy.

25. PySpider

PySpider è anche uno dei migliori strumenti di scraping web gratuiti che è un web crawler basato su Python. Di seguito sono elencate alcune funzionalità di questo strumento.

- Presenta un’architettura distribuita e supporta le pagine Javascript.

- Potresti avere molti crawler in questo modo. PySpider può archiviare dati su qualsiasi back-end tu scelga, inclusi MongoDB, MySQL, Redis e altri.

- Sono disponibili code di messaggi come RabbitMQ, Beanstalk e Redis.

- Uno dei vantaggi di PySpider è la sua semplice interfaccia utente, che consente di modificare gli script, monitorare le attività in esecuzione ed esaminare i risultati.

- Le informazioni possono essere scaricate nei formati JSON e CSV.

- PySpider è lo scrape di Internet da considerare se stai lavorando con un’interfaccia utente basata su un sito web.

- Funziona anche con siti Web che utilizzano molto AJAX.

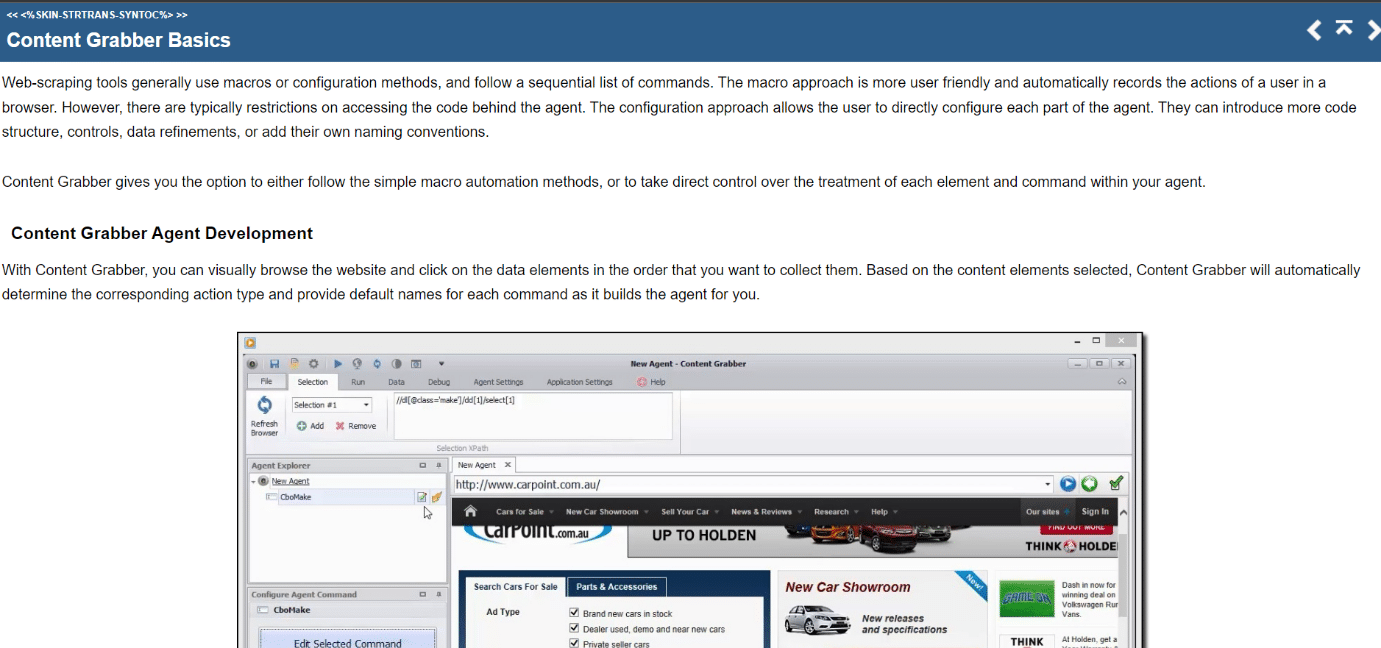

26. Raccoglitore di contenuti

Content Grabber è uno strumento di scraping online visivo con un’interfaccia point-and-click facile da usare per la selezione degli elementi. Di seguito sono riportate le caratteristiche di questo strumento.

- CSV, XLSX, JSON e PDF sono i formati in cui i dati possono essere esportati. Per utilizzare questo strumento sono richieste competenze di programmazione intermedie.

- Impaginazione, pagine a scorrimento illimitato e pop-up sono tutti possibili con la sua interfaccia utente.

- Dispone inoltre di elaborazione AJAX/Javascript, una soluzione captcha, supporto per espressioni regolari e rotazione IP (usando Nohodo).

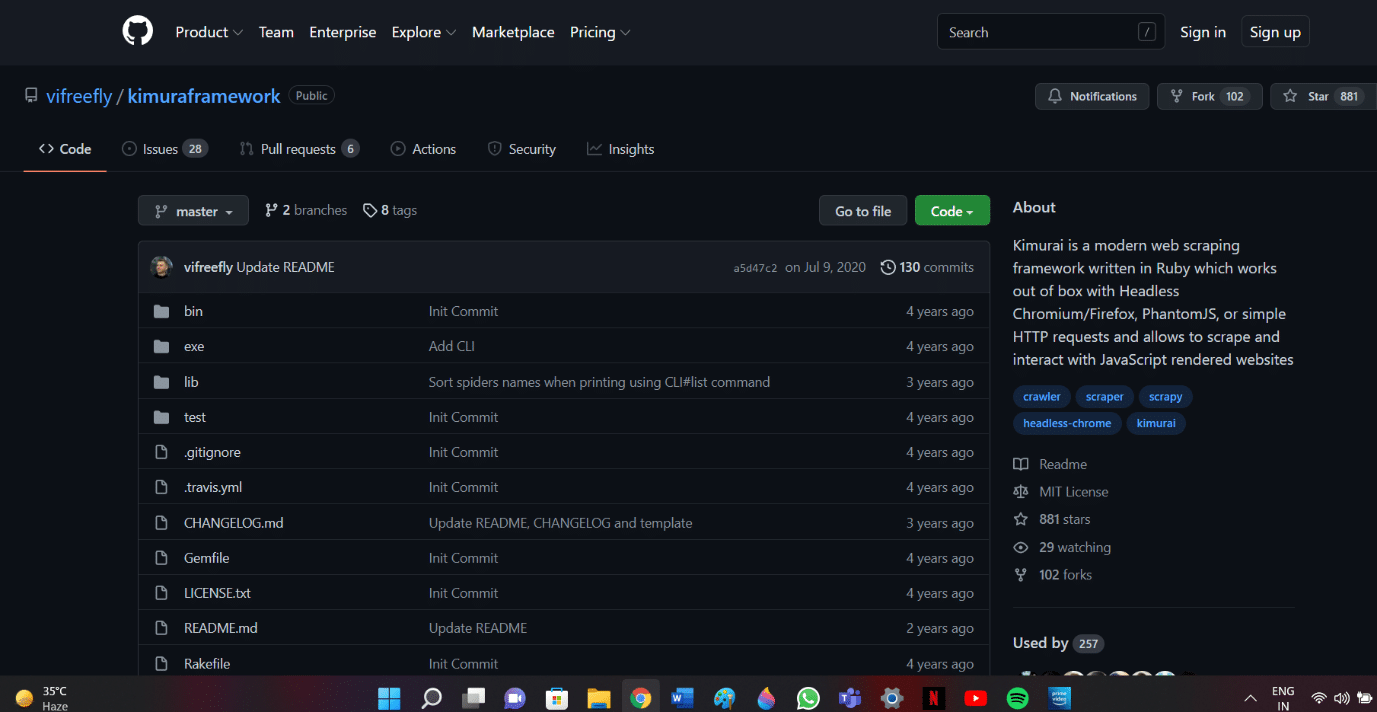

27. Kimurai

Kimurai è un framework di scraping web di Ruby per la creazione di scraper e l’estrazione di dati. È anche uno dei migliori strumenti di scraping web gratuiti. Ecco alcune caratteristiche di questo strumento.

- Ci consente di raschiare e interagire con le pagine Web prodotte da JavaScript immediatamente con le query Headless Chromium/Firefox, PhantomJS o HTTP di base.

- Ha una sintassi simile a Scrapy e opzioni configurabili tra cui l’impostazione di un ritardo, la rotazione dei programmi utente e le intestazioni predefinite.

- Interagisce anche con le pagine Web utilizzando il framework di test Capybara.

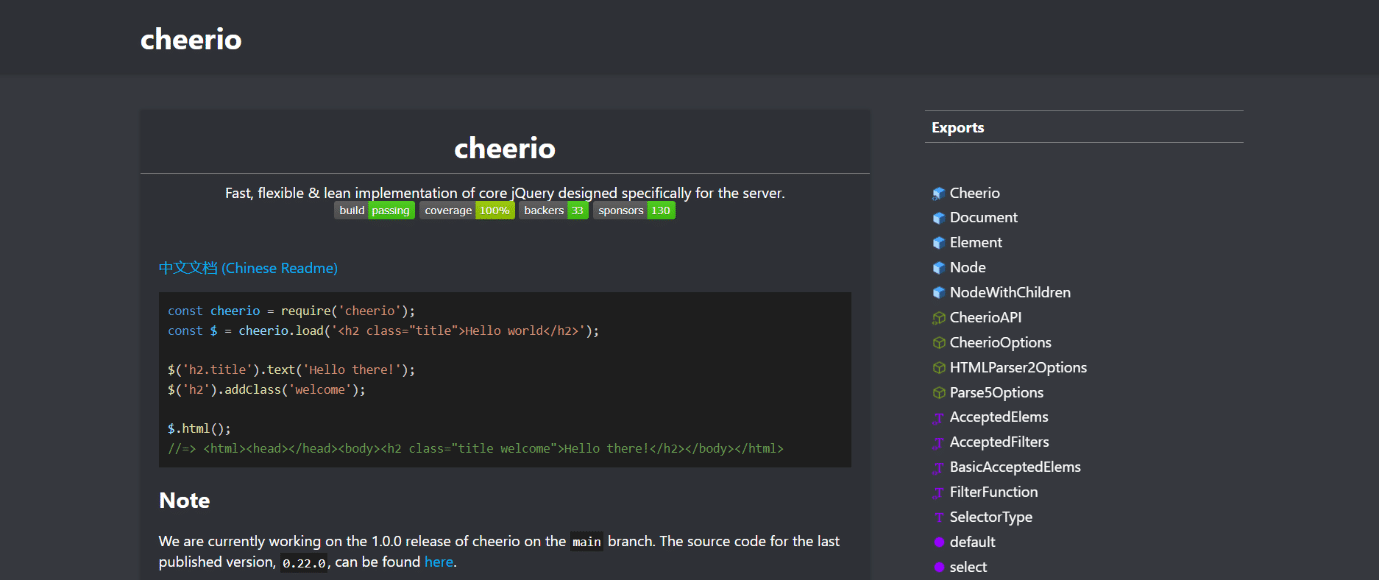

28. Cheerio

Cheerio è un altro dei migliori strumenti di web scraping. È un pacchetto che analizza documenti HTML e XML e consente di operare con i dati scaricati utilizzando la sintassi jQuery. Di seguito sono riportate le caratteristiche di questo strumento.

- Se stai sviluppando un web scraper JavaScript, l’API Cheerio offre una scelta rapida per l’analisi, la modifica e la visualizzazione dei dati.

- Non esegue il rendering dell’output in un browser Web, non applica CSS, non carica risorse esterne o non esegue JavaScript.

- Se una di queste funzionalità è richiesta, dovresti guardare PhantomJS o JSDom.

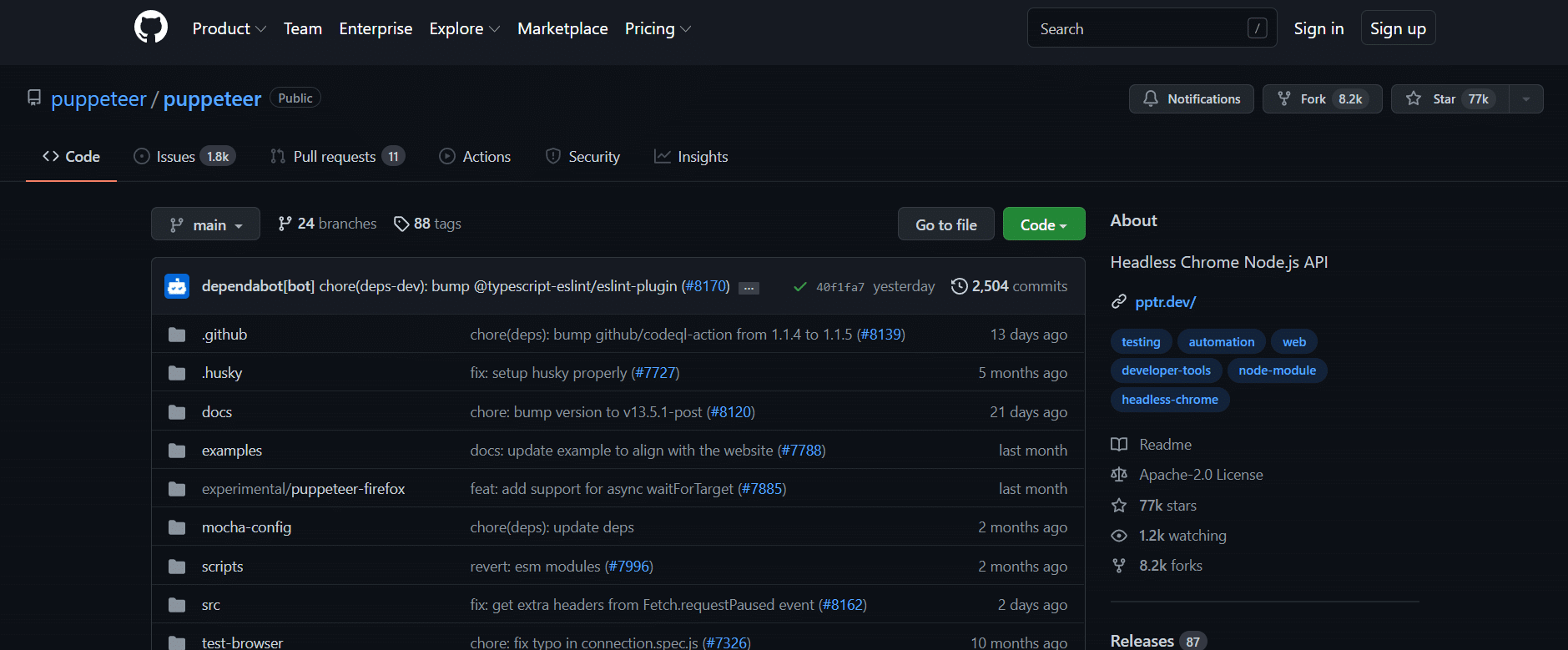

29. Burattinaio

Puppeteer è un pacchetto Node che ti consente di gestire il browser Chrome senza testa di Google utilizzando un’API potente ma semplice. Di seguito sono elencate alcune funzionalità di questo strumento.

- Funziona in background, eseguendo comandi tramite un’API.

- Un browser headless è in grado di inviare e ricevere richieste ma manca di un’interfaccia utente grafica.

- Puppeteer è la soluzione giusta per l’attività se le informazioni che stai cercando vengono generate utilizzando una combinazione di dati API e codice Javascript.

- Puoi imitare l’esperienza dell’utente digitando e facendo clic negli stessi punti in cui lo fanno.

- Puppeteer può anche essere utilizzato per acquisire schermate di pagine Web visualizzate per impostazione predefinita all’apertura di un browser Web.

30. Drammaturgo

Playwright è una libreria Microsoft Node progettata per l’automazione del browser. È un altro dei migliori strumenti di scraping web gratuiti. Ecco alcune caratteristiche di questo strumento.

- Offre un’automazione web cross-browser competente, affidabile e rapida.

- Playwright aveva lo scopo di migliorare i test automatizzati dell’interfaccia utente rimuovendo le irregolarità, aumentando la velocità di esecuzione e fornendo informazioni su come funziona il browser.

- È una moderna applicazione di automazione del browser paragonabile a Puppeteer in molti modi e viene fornita con browser compatibili preinstallati.

- Il suo principale vantaggio è la compatibilità tra browser poiché può eseguire Chromium, WebKit e Firefox.

- Playwright si integra regolarmente con Docker, Azure, Travis CI e AppVeyor.

31. PJScrape

PJscrape è un toolkit di scraping online basato su Python che utilizza Javascript e JQuery. Di seguito sono riportate le caratteristiche di questo strumento.

- È progettato per funzionare con PhantomJS, quindi puoi eseguire lo scraping dei siti dalla riga di comando in un contesto completamente renderizzato e abilitato a Javascript, senza bisogno di un browser.

- Ciò implica che puoi accedere non solo al DOM, ma anche a variabili e funzioni Javascript, nonché al contenuto caricato in AJAX.

- Le funzioni dello scraper vengono valutate nel contesto dell’intero browser.

***

Ci auguriamo che questa guida sia stata utile sui migliori strumenti di web scraping. Facci sapere quale strumento trovi facile per te. Continua a visitare la nostra pagina per ulteriori suggerimenti e trucchi interessanti e lascia i tuoi commenti qui sotto.