L’Era dei Dati e la Necessità del Data Wrangling

Nell’odierna era digitale, ci troviamo di fronte a un’enorme quantità di dati, misurabile in terabyte e petabyte, che cresce a un ritmo esponenziale. La sfida cruciale è trasformare questi dati grezzi in informazioni utili, che ci consentano di ottimizzare i servizi e prendere decisioni informate. Aziende di ogni settore hanno bisogno di dati affidabili, aggiornati e di facile comprensione per alimentare i loro processi di *knowledge discovery*.

Per questo motivo, le organizzazioni stanno adottando diverse metodologie di analisi per identificare e utilizzare dati di alta qualità. Ma da dove si comincia? La risposta risiede nel *data wrangling*, il processo fondamentale per preparare i dati.

Cos’è il Data Wrangling?

Il data wrangling è l’attività di pulizia, strutturazione e trasformazione dei dati grezzi in formati che ne semplificano l’analisi. Spesso, questo processo è necessario quando si lavora con set di dati complessi e disorganizzati, non immediatamente pronti per essere elaborati. Il data wrangling consente di convertire i dati grezzi in uno stato raffinato, o dati raffinati in uno stato ottimizzato, adeguati per l’utilizzo a livello di produzione.

Le principali attività del data wrangling includono:

- Combinazione di molteplici set di dati in un unico insieme più grande per l’analisi.

- Identificazione e gestione dei dati mancanti.

- Rimozione di valori anomali o errori nei dati.

- Standardizzazione dei formati di input.

I grandi volumi di dati coinvolti nel data wrangling spesso richiedono l’automazione per garantire la precisione e la qualità, poiché l’ottimizzazione manuale non è più sufficiente.

Gli Scopi del Data Wrangling

Oltre a preparare i dati per l’analisi, il data wrangling ha altri obiettivi importanti, tra cui:

- Generare dati validi e pertinenti a partire da dati grezzi, supportando le decisioni aziendali.

- Convertire i dati grezzi in formati compatibili con i sistemi Big Data.

- Ridurre il tempo necessario agli analisti di dati per creare modelli, grazie a dati già organizzati.

- Garantire coerenza, completezza, usabilità e sicurezza di tutti i dati archiviati o utilizzati in un data warehouse.

Approcci Comuni al Data Wrangling

Fase di Scoperta

Prima di iniziare la preparazione dei dati, i data engineer devono comprendere a fondo i dati stessi: come sono archiviati, le loro dimensioni, i record inclusi, i formati di codifica e tutti gli altri attributi descrittivi.

Fase di Strutturazione

Questo passaggio prevede l’organizzazione dei dati in formati facilmente utilizzabili. Può comportare la riorganizzazione dei set di dati in base alla struttura delle colonne, al numero di righe e all’ottimizzazione di altri attributi, per semplificarne l’analisi.

Fase di Pulizia

Dopo la strutturazione, i dati devono essere liberati da errori e anomalie che potrebbero distorcerne l’interpretazione. Questa fase include la rimozione di duplicati, la gestione di celle vuote, la standardizzazione degli input e la correzione di nomi e attributi ambigui.

Fase di Arricchimento

Una volta completate la strutturazione e la pulizia, si valuta l’utilità dei dati. È possibile incrementare la qualità aggiungendo dati mancanti da altri set, fornendo un quadro più completo.

Fase di Convalida

Questo è un processo iterativo che verifica la qualità, la coerenza, l’usabilità e la sicurezza dei dati. La convalida assicura che tutte le attività di trasformazione siano state eseguite correttamente e che i set di dati siano pronti per l’analisi e la modellazione.

Fase di Presentazione

Al termine di tutte le fasi, i set di dati preparati vengono presentati/condivisi all’interno dell’organizzazione per l’analisi. In questa fase, viene anche condivisa la documentazione delle fasi di preparazione e dei metadati generati durante il processo di wrangling.

Strumenti per il Data Wrangling

Talend

Talend è una piattaforma unificata per la gestione dei dati, suddivisa in tre aree principali per garantire la qualità e l’affidabilità dei dati. Offre strumenti per l’integrazione, l’applicazione, l’integrità e la governance dei dati. Il data wrangling in Talend avviene tramite un’interfaccia utente intuitiva, basata su browser, che consente la preparazione di dati in batch, in blocco e in tempo reale: dalla profilazione alla pulizia, fino alla documentazione.

Talend gestisce l’intero ciclo di vita dei dati, bilanciando accuratamente la disponibilità, l’usabilità, la sicurezza e l’integrità di tutte le informazioni aziendali.

Talend offre una soluzione unificata per l’integrazione rapida dei dati da fonti disparate (database, archivi cloud e API), con la possibilità di trasformare e mappare tutti i dati con controlli di qualità integrati.

L’integrazione dati in Talend avviene tramite strumenti self-service, come connettori che permettono agli sviluppatori di acquisire automaticamente dati da qualsiasi fonte e classificarli in modo appropriato.

Caratteristiche Principali di Talend

- Integrazione Universale dei Dati: Gestisce diversi tipi di dati da varie fonti, sia cloud che on-premise.

- Flessibilità: Permette di costruire pipeline di dati indipendenti dal fornitore o dalla piattaforma, e di eseguirle ovunque.

- Qualità dei Dati: Utilizza funzioni di apprendimento automatico per la deduplicazione, la convalida e la standardizzazione.

- Supporto per Integrazioni API e Applicazioni: Condivide facilmente i dati tramite API, con funzionalità avanzate di mappatura e trasformazione.

R

R è un linguaggio di programmazione molto efficace per l’analisi esplorativa dei dati, sia in ambito scientifico che aziendale. È un software gratuito per calcoli statistici e grafica, e offre un ambiente completo per il confronto, la modellazione e la visualizzazione dei dati. L’ambiente R fornisce una vasta gamma di pacchetti software, mentre il linguaggio R include tecniche statistiche, di clustering, classificazione, analisi e visualizzazione.

Caratteristiche Principali di R

- Ampia Gamma di Pacchetti: Offre oltre 10.000 pacchetti ed estensioni standardizzate disponibili tramite CRAN, semplificando l’analisi e il data wrangling.

- Elevata Potenza: Consente di eseguire manipolazioni complesse su oggetti di dati e set di dati in tempi rapidi.

- Supporto Multipiattaforma: Funziona su diversi sistemi operativi ed è compatibile con altri linguaggi di programmazione.

Trifacta

Trifacta è una piattaforma cloud interattiva per la profilazione dei dati basata su machine learning e analisi. L’obiettivo è creare dati comprensibili, indipendentemente dalla loro complessità. Gli utenti possono rimuovere i duplicati e gestire le celle vuote tramite deduplicazione e trasformazioni lineari.

Trifacta monitora i valori anomali e i dati non validi, e offre un’interfaccia drag-and-drop per la classificazione e la trasformazione intelligente dei dati, accelerando la preparazione. Il data wrangling in Trifacta avviene attraverso profili visivi che possono essere compresi sia da personale tecnico che non tecnico.

Trifacta gestisce l’importazione di dati da varie fonti e semplifica la preparazione dei dati.

Caratteristiche Principali di Trifacta

- Integrazioni Cloud Senza Interruzioni: Supporta la preparazione dei dati in ambienti cloud o ibridi, indipendentemente da dove si trovino i dati.

- Metodi Multipli di Standardizzazione: Offre diversi meccanismi per identificare i modelli nei dati e standardizzare gli output.

- Flusso di Lavoro Semplice: Organizza i lavori di preparazione dei dati in flussi che contengono dataset e ricette (passaggi di trasformazione).

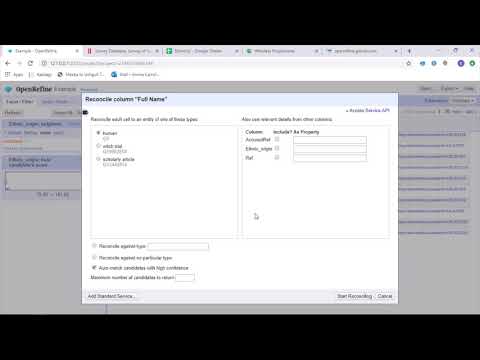

OpenRefine

OpenRefine è uno strumento open source per la gestione di dati disordinati. Consente di esplorare set di dati in pochi secondi e di applicare trasformazioni complesse per ottenere i formati desiderati. Si basa su filtri ed espressioni regolari per il data wrangling e offre un linguaggio per la visualizzazione dei dati tramite faccette, filtri e ordinamenti. OpenRefine gestisce i dati come progetti, dove i set di dati possono essere caricati da diversi file, URL web e database.

Tramite le espressioni, gli sviluppatori possono estendere le funzioni di pulizia e trasformazione dei dati, ad esempio dividendo o unendo celle, personalizzando faccette e recuperando dati da URL esterni.

Caratteristiche Principali di OpenRefine

- Strumento Multipiattaforma: Compatibile con Windows, Mac e Linux.

- Ampia Gamma di API: Supporta l’interazione degli utenti con i dati attraverso API OpenRefine, di estensione dati, di riconciliazione e altro.

Datameer

Datameer è uno strumento SaaS per la trasformazione dei dati, creato per semplificare la raccolta e l’integrazione attraverso processi di ingegneria del software. Consente l’estrazione, la trasformazione e il caricamento di dati in data warehouse cloud come Snowflake.

Datameer funziona con formati standard come CSV e JSON, consentendo l’importazione di dati per l’aggregazione. Offre documentazione simile a un catalogo, profilazione approfondita e discovery per soddisfare tutte le esigenze di trasformazione dei dati. Datameer visualizza un profilo dei dati dettagliato, che permette di individuare valori non validi o mancanti, e di comprendere la forma generale dei dati.

Datameer trasforma i dati per analisi significative tramite stack efficienti e funzioni simili a Excel, con un’interfaccia utente ibrida, con e senza codice, adatta a team di analisi che possono creare pipeline ETL complesse.

Caratteristiche Principali di Datameer

- Ambienti Utente Multipli: Ambienti di trasformazione dati per utenti con e senza competenze tecniche.

- Spazi di Lavoro Condivisi: I team possono collaborare e riutilizzare modelli per accelerare i progetti.

- Documentazione Ricca: Supporta la documentazione dei dati di sistema e quella generata dall’utente tramite metadati, tag e commenti.

Conclusioni

L’analisi dei dati è un processo complesso che richiede che i dati siano adeguatamente organizzati per ottenere conclusioni significative e fare previsioni. Gli strumenti di data wrangling aiutano a formattare grandi quantità di dati grezzi per consentire l’esecuzione di analisi avanzate. Scegliete lo strumento più adatto alle vostre esigenze e diventate esperti di analisi!

Potrebbe interessarti anche: I migliori strumenti CSV per convertire, formattare e convalidare.